گروه جامعه و اقتصاد «سدید»؛ «پیا مالنی»[۱] ،فارغ التحصیل اقتصاد از دانشگاه هاروارد، اقتصاد دان ارشد و و مدیر مرکز نوآوری، رشد و جامعه در «موسسه تفکر اقتصادی جدید»[۲] است. وی در مقالهای که وب سایت همین موسسه آن را منتشر کرده است به موضوع استفاده از هوش مصنوعی در بازارها میپردازد. به گفته وی هر چه زمان میگذرد هوش مصنوعی جای خود را در بازارهای بین المللی باز میکند. پیشبینی میشود بازار جهانی هوش مصنوعی تا سال ۲۰۲۷ به ۲۶۷ میلیارد دلار برسد. وی فضایی را برای سالهای آینده ترسیم میکند که در آن هوش مصنوعی به ابزار قدرتمندتر از انسان تبدیل شده و با استفاده از حفرههای قانونی و بدون در نظر گرفتن پیوستهای اخلاقی به بیشینه سازی سود به هر قیمتی میپردازد و این نوع جدیدی از تهدید است که تا کنون سابقه نداشته است.

هوش مصنوعی قدرتمندتر از انسان

تا همین اواخر این که انسانها بهطور کلی حتی از پیشرفتهترین ماشینهای ما باهوشتر بودهاند، منبع آرامش بوده است. شرکت پژوهشی غیرانتفاعی هوش مصنوعی «اوپن آی ای»[۳] در یک دوره کوتاه بین ژوئن ۲۰۲۰ و نوامبر ۲۰۲۲، مجموعهای از رابطها را منتشر کرد و از عموم مردم دعوت کرد تا با دو مدل جدید یادگیری ماشینی[۴] بازی کنند. این جفت به نامهای «دال- ای»[۵] و «چت جی بی تی»[۶] به مردم عادی اجازه میداد تا از ابزارهای طبیعی انسانی برای تعامل مستقیم با موتورهای هوشمند مصنوعی استفاده کنند و نیاز به توانایی کدنویسی یا آشنایی با محاسبات فراتر از وبگردی را دور بزنند. نتایج، برای بسیاری باورکردنی نبود. آنها ناگهان متوجه شدند که هوش مصنوعی چقدر به سرعت قدرتمند شده است.

زمانی که «ایلان ماسک» چند ماه پیش توییتی معمایی به نام «BasedAI» منتشر کرد، توجهها را به پیامدهای سیاسی مدلهای قدرتمند جدید هوش مصنوعی معطوف کرد

زمانی که «ایلان ماسک» چند ماه پیش توییتی معمایی به نام «BasedAI» منتشر کرد، توجهها را به پیامدهای سیاسی مدلهای قدرتمند جدید هوش مصنوعی معطوف کرد. توییتی با عنوان «BasedAI» که یک «میم» «Woke AI» و Closed AI»» را در حال نبرد را نشان داد و سپس «Based AI» با چوب بیسبال وارد میشود و در این نبرد پیروز میشود. اما این اصلا برای چه بود؟ در حالی که میمها ممکن است احمقانه و مبهم به نظر برسند، اما در واقع این توئیت اشارهای به بحث بین مجموعه کوچکی از پیشگامان هوش مصنوعی بود که بهطور جدی در کنفرانسی در «پورتوریکو» درباره ایمنی هوش مصنوعی آغاز شد. دو جلسه در روز یکشنبه ۴ ژانویه ۲۰۱۵ از اهمیت ویژهای برخوردار بود. این جلسات «ایلان ماسک»، «نیک بوستروم»[۷]، «الیزر یودکوفسکی»[۸]، «دمیس حاسابیس»[۹]، «جان تالین»[۱۰] و دیگران را گرد هم آورد تا درباره ایمنی هوش مصنوعی در سطح انسانی و فراتر از آن بحث کنند. این جلسات از این جهت متمایز بود که احتمالاً اولین بار بود که آنچه که به عنوان یک دغدغه آکادمیک ویژه گروههای کوچک آیندهپژوهان هوش مصنوعی در خلیج شرقی سانفرانسیسکو دیده میشد توجه صنعتگران میلیاردر (مانند ماسک) و روشنفکران عمومی با پلتفرمهای شخصی عظیم (مانند سام هریس) را نیز به خود جلب کرده بود. از بین بازیگران اصلی دنیای هوش مصنوعی در ۸ سال بعد، به نظر میرسد که تنها «سم آلتمن»[۱۱] در آن جلسه حضور نداشته است.

فرمان و تراز هوش مصنوعی

هر موتور هوش مصنوعی توسط مقادیری هدایت میشود که هم ضمنی و هم صریح هستند. یک موتور هوش مصنوعی آموزش دیده در روزنامههای انگلیسی زبان کشور هند فکر میکند که «سانجی» و «سانیتا» اسم افراد هستند در حالی که روزنامههای نیوزیلند ممکن است همین را درباره «الیور» و «آملیا» بگویند. این نمونهای از مقادیر غیرفعال است که بر اساس نحوه آموزش مدلها به ارث میرسد. اما هدف ماسک لایه دوم بود. «AI Woke» یا «هوش مصنوعی بیدار» در واقع کاووش در مدلهایی بود که به نظر میرسد ارزشهای ایدئولوژیک سازندگان هوش مصنوعی را بالاتر از برآورده شدن درخواست و رضایت کاربر در اولویت قرار میدهند.

این ایده که یک سیستم هوشمند مصنوعی نباید به سادگی آنچه گفته میشود را انجام دهد، عموما مورد توافق همه افراد در این زمینه است. تعداد زیادی شکایت در مورد تعصب سیاسی «چت جی پی تی» وجود دارد و این احتمال وجود دارد که ماسک واقعا با نگرانی در مورد این مسئله به سرمایه گذاری در هوش مصنوعی ترغیب شده باشد. اما باید توجه داشت که پیشبینی میشود بازار جهانی هوش مصنوعی تا سال ۲۰۲۷ به ۲۶۷ میلیارد دلار برسد. این مدلهای زبانی پرهزینه هستند و تخمین زده میشود که برنامه «چت جی پی تی» روزانه حدود ۱۰۰ هزار دلار هزینه دارد. اما تأثیر بر بهره وری بهطور بالقوه میتواند چندین برابر آن باشد. به همین دلیل است که حتی قبل از اینکه ماسک ماجراجویی خود را آغاز کند، تقریباً همه غولهای فناوری تلاش میکنند بخشی از این بازار تصاحب کنند.

«مایکروسافت»، یکی از سرمایهگذاران اصلی «اوپن آی ای»، در حال استفاده از این فناوری در موتور جستجوی خود خود تحت عنوان «بینگ»[۱۲] و همچنین برنامههای دیگر خود است. گوگل که مدتی است در حال توسعه مدل زبانی خود برای اپلیکیشنهای محاورهای به نام «لامدا» [۱۳]است، به تازگی «چت بات» هوش مصنوعی خود را تحت عنوان «بارد»[۱۴] منتشر کرده است. برخی ممکن است در این رابطه هشدار یکی از مهندسان گوگل را را به خاطر بیاورند که ادعا کرد این فناوری واقعاً از خود احساسات انسانی بروز میدهد که گواهی بر قدرت این مدلهای زبانی بزرگ در بازتولید پاسخها و تعاملات شبیه به انسان است.

انتشار تجاری این چتباتها و آگاهی گسترده ناگهانی از قدرت و تواناییهای آنها، بحث در مورد خطرات هوش مصنوعی متخاصم و نیاز به «همسویی هوش مصنوعی» را تقویت کرده است. «الیزر یودکوسکی»[۱۵]، محقق قدیمی هوش مصنوعی و موسس موسسه تحقیقات هوش ماشینی[۱۶]، در پادکستی که بهطور گسترده در مورد آن صحبت شد، پیشرفتها در زمینه هوش مصنوعی ررا در ادامه مسیر به سمت روز قیامت و نابودی توصیف کرد.

تاریخچه هوش مصنوعی

طنز ماجرا اینجاست که خود «اوپن آی ای» شرکتی که «چت جی پی تی» و و جانشین بسیار قویتر آن «جی پی تی -۴» را توسعه داد، بهعنوان یک سازمان غیرانتفاعی که تا حدودی توسط ایلان ماسک تأمین مالی شد و در پاسخ به «یودکوفسکی» که او را در مورد خطرات هوش مصنوعی غیرهمسو و توانایی آن برای از بین بردن نوع بشر متقاعد کرد، راهاندازی شد. در واقع یکی از دلایل تاسیس این شرکت پیشگام در هوش مصنوعی نگرانیها از خطرات هوش مصنوعی بود. هدف اصلی این سازمان غیرانتفاعی ایجاد «هوش مصنوعی ایمن» بود که با پیشرفت انسان همسو باشد. «جنبش نوع دوستی مؤثر»[۱۷] که با سقوط یکی از حامیان اصلی خود «سام بنکمن فرید»[۱۸] بدنام شد، از جامعه به اصطلاح عقل گرا بیرون آمد که تا حدی توسط یودکوفسکی تأسیس شد. به گفته این جنبش منابع باید در مسیری که بیشترین بازده را دارد نوع دوستی را ترویج میکند به کار گرفته شود. اگر هوش مصنوعی متخاصم موجودیت بشریت را تهدید کند، قطعا بهترین بازده از توسعه راههایی برای حفاظت از بشریت در برابر این سرنوشت حاصل خواهد شد و سرمایه گذاری منابع قابل توجهی را به سمت تحقیقات هم ترازسازی هوش مصنوعی سوق خواهد داد. خطرناکترین مسیر، از این منظر، انتشار گسترده تحقیقات هوش مصنوعی و باز کردن آن برای توسعه تجاری بیشتر برای کسب سود، بدون نگرانی درباره ایمنی هوش مصنوعی است.

محققان مایکروسافت در توصیف کار خود با «جی پی تی -۴» ادعا میکنند، که ما نشان میدهیم «جی پی تی -۴» فراتر از تسلط بر زبان، میتواند کارهای جدید و دشواری را که شامل ریاضیات، کدنویسی، بینش، پزشکی، قانون، روانشناسی میشود را بدون نیاز به هیچ انگیزه خاصی حل کند

شرکت «اوپن آی ای» از آن زمان از یک شرکت غیرانتفاعی به یک شرکت انتفاعی تبدیل شده و ایلان ماسک از هیات مدیره آن استعفا داده است. «سام آلتمن»، یکی از بنیانگذاران و مدیر عامل فعلی، مدتهاست بر توسعه «هوش مصنوعی عمومی»[۱۹]، سیستمهای هوش مصنوعی که به اندازه یا هوشمندتر از انسانها هستند، تمرکز کرده است. با توجه به منشاء و خاستگاه «اوپن آی ای» او البته از سناریوی آخرالزمانی هوش مصنوعی که «یودکوفسکی» و دیگران برجسته میکنند غافل نیست. «سام آلتمن» ادعا میکند که مزایای هوش مصنوعی بسیار بیشتر از هزینهها و مخاطرات آن خواهد بود، در ماه دسامبر ۲۰۲۲ توییت کرد: «زمانی که ما به سمت سیستمهای هوش مصنوعی عمومی حرکت میکنیم، لحظات ترسناکی خواهیم داشت و اختلالات قابل توجهی خواهیم داشت، اما نکات مثبت آن میتواند آنقدر شگفتانگیز باشد که ارزش غلبه بر چالشهای بزرگ برای رسیدن به آنجا را دارد.» او در درجه اول بر پیامدهای اقتصادی هوش مصنوعی عمومی بر نیروی کار متمرکز بوده است.

چقدر به تحقق چشمانداز آلتمن در زمینه هوش مصنوعی عمومی نزدیک هستیم؟ محققان مایکروسافت در توصیف کار خود با «جی پی تی -۴» ادعا میکنند، که ما نشان میدهیم «جی پی تی -۴» فراتر از تسلط بر زبان، میتواند کارهای جدید و دشواری را که شامل ریاضیات، کدنویسی، بینش، پزشکی، قانون، روانشناسی و... میشود را بدون نیاز به هیچ انگیزه خاصی حل کند. علاوه بر این، در تمام این وظایف، عملکرد «جی پی تی -۴» بهطور قابل توجهی به عملکرد سطح انسانی نزدیک است و اغلب از مدلهای قبلی مانند «چت جی پی تی» پیشی میگیرد. با توجه به گستردگی و عمق قابلیتهای «جی پی تی -۴»، ما معتقدیم که میتوان آن را بهعنوان نسخه اولیه (اما هنوز ناقص) یک سیستم هوش عمومی مصنوعی (AGI) در نظر گرفت. در حالی که این ممکن است هنوز هوش مصنوعی عمومی نباشد، تنها تکرار فعلی در یک فرآیند در حال پیشرفت است که به توسعه ادامه خواهد داد. تاثیر آن بر بازار کار در کوتاه مدت و بلند مدت پیچیده خواهد بود.

در حالی که ماسک آشکارا ابراز نگرانی کرده است که سرمایه گذاری ۱۰۰ میلیون دلاری او در یک موسسه غیرانتفاعی متمرکز بر هوش مصنوعی ایمن به ۳۰ میلیارد دلار ارزش بازار تبدیل شده است که بهطور موثر توسط مایکروسافت کنترل میشود. به نظر میرسد نگرانی او از سوگیری سیاسی نهفته در سیستمهای کنونی، برای جذب او به این بازار بالقوه بسیار پرسود کافی باشد. باید از تمرکز او بر هوش مصنوعی «Based» حدس زد که این باور که هوش مصنوعی به اصطلاح «woke» نشان دهنده سوگیری سیاسی است، و هوش مصنوعی «closed» نشان دهنده کنترل شرکت است، که هوش مصنوعی «Based» نشان دهنده «حقیقت» خواهد بود.

با این حال، تصور اینکه ماسک واقعاً پس از مواجهه نزدیک با چالشهایی مثل افزایش سخنان نژادپرستانه در توییتر چنین دیدگاه سادهای داشته باشد، دشوار است. در واقع، زمانی که او تصمیم گرفت حساب اختصاصی ردیابی جت شخصی خود را مسدود کند و ادعا کرد که این کار نشان دهنده خطر مستقیم امنیت شخصی است، پیچیدگی پیرامون مسائل «آزادی بیان» و «حقیقت» را برجسته کرد. پس نمیتوان به این فکر کرد که آیا مساله واقعی که ماسک را وارد رقابت هوش مصنوعی میکند، بیشتر به اقتصاد مربوط است تا تعهد به آزادی بیان.

رباتهای انساننما میتوانند تبلیغات بسیار مناسب را با کمترین هزینه، از جمله ویدیو و صوت جعلی، انجام دهند، توانایی کنترل بازیگران بد به سرعت رو به وخامت میرود. پیامدهای آن برای محیط سیاسی جهانی وحشتناک است

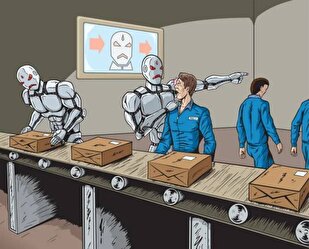

البته پیامدهای سیاسی، فرهنگی و زندگی روزمره هوش مصنوعی که به سرعت در حال توسعه است را نباید نادیده گرفت. از آنجا که رباتهای انساننما میتوانند تبلیغات بسیار مناسب را با کمترین هزینه، از جمله ویدیو و صوت جعلی، انجام دهند، توانایی کنترل بازیگران بد به سرعت رو به وخامت میرود. پیامدهای آن برای محیط سیاسی جهانی وحشتناک است. اما این سوال که آیا پیامدهای اصلی انقلاب کنونی هوش مصنوعی در درجه اول اقتصادی خواهد بود یا سیاسی به نظر من تنها تا حدی به بحث جاری در مورد پیامدهای اقتصادی مستقیم هوش مصنوعی بر بازار کار مربوط میشود. مسئله این است که آیا در بلندمدت هوش مصنوعی بهرهوری و دستمزد انسان را افزایش میدهد یا با جایگزینی به جای کارگران منجر به بیکاری گسترده میشود. آینده بیشتر منوط به نقشی است که چارچوبهای اقتصادی ما در توسعه و ساختار هوش مصنوعی ایفا خواهند کرد.

در تلاش برای درک مسائل پیرامون رسانههای اجتماعی و ماهیت سمی و اعتیادآور پلتفرمهای اصلی امروزی، من پیش از این در یادداشتی به نقش بازارها در رساندن اینترنت از ریشههای ایده آل گرایانه اولیه اش به فضایی تحت کنترل انحصارات شرکتی اشاره کردم.

هوش مصنوعی، بازارها، دموکراسی و قانون

وقتی «آدام اسمیت»[۲۰] کتاب «ثروت ملل»[۲۱] را نوشت، استعاره او از دست نامرئی تلاشی آشکار برای متمدن کردن بازار در ذهن خوانندگانش بود. او با انسانسازی بازار بهعنوان «دست نامرئی» تلاش کرد به ما نشان دهد که مکانیسم بازار آزاد را میتوان به عنوان یک مکانیزم متفکرانه و هوشمندانه مرتبط با یک ابرهوش تصور کرد که در نهایت به نفع انسان کار میکند. در نقطه مقابل، متفکر آنارشیست «پیتر کروپوتکین»[۲۲]، انسانها را از دریچه کلونی مورچهها مینگریست که همگی به صورت جداگانه برای منافع عمومی کلونی کار میکنند. در هر دوی این سناریوها، بازار و سیاست به دنبال ایده انسجام هدف از منافع متنوعی هستند که به عبارت «وحدت در عین کثرت»[۲۳] معنا میدهد.

اما چه اتفاقی میافتد وقتی ما برای اولین بار، کارگزارهای هوشمند مصنوعی را در بازار یا ساختارهای سیاسی خود ترکیب میکنیم؟ پاسخ کوتاه این است که هیچ تضمینی وجود ندارد که آنها به همین شیوه در این رژیم جدید به کار خود ادامه دهند. بازار آدام اسمیت را میتوان به یک نظریه فیزیکی کلاسیک تشبیه کرد که ناگهان به قلمرو نسبیتی یا کوانتومی سوق داده میشود. اجازه دهید سناریوی زیر را که سناریوی بازار هوش مصنوعی مینامیم بررسی کنیم که بر دو فرض استوار است: هیچ مانع یا محدودیت طبیعی وجود ندارد که یادگیری ماشین را مجبور کند قبل از رسیدن به هوش مصنوعی دچار رکود شود. این که بازار، پروژههای پیشرو هوش مصنوعی را قبل از ایجاد هرگونه تغییر قابل توجهی در قوانین مربوط به وظایف امانتداری در قبال سهامداران، تصاحب میکند.

هیچ مانع یا محدودیت طبیعی وجود ندارد که یادگیری ماشین را مجبور کند قبل از رسیدن به هوش مصنوعی دچار رکود شود. این که بازار، پروژههای پیشرو هوش مصنوعی را قبل از ایجاد هرگونه تغییر قابل توجهی در قوانین مربوط به وظایف امانتداری در قبال سهامداران، تصاحب میکند

واضح است که ما به اندازه کافی نمیدانیم که آیا مانع تکنولوژیکی یا علمی وجود دارد که سیستمهای یادگیری ماشین فعلی را از دستیابی به هوش ابرانسانی واقعی باز دارد یا خیر. دلیلی هم نمیبینیم که نتوانیم قوانینی در این زمینه وضع کنیم؛ بنابراین اگر هر یک از دو فرض بالا نقض شود، نیازی به فراتر رفتن از مرحله فعلی خود در مسیر سناریوی بازار هوش مصنوعی نمیبینیم. با این حال، چیزی که ما میگوییم این است که اگر این آینده مورد نظر ما نباشد، ممکن است این یکی از آخرین فرصتها برای یافتن یک راه فرار باشد.

مراحل مختلف سناریوی هوش مصنوعی بازار

چگونه ممکن است این موضوع تحت مجموعه مقررات فعلی بازار انجام شود؟ انجام این آزمایش فکری را میتوان با تصور دوباره رابطه گذشته ما با هوش مصنوعی در پرتو مراحل مختلف آغاز کرد:

مرحله صفر: دهههای ۱۹۸۰ تا ۲۰۰۵ در ابتداییترین مرحله، به سادگی نه پول کافی و نه اهرمی در ارتباط با هوش مصنوعی بی نظم وجود دارد که ارزش تمرکز بر قدرت واقعی را داشته باشد. به یک معنا، این دوره نشان دهنده معصومیت اکثر تکنولوژیهایی است که در آن نوآوران، سرگرمی سازان، و رویاپردازان را بیش از سرمایه گذاران، مدیران، شرکت ها، ارتش و سرمایه گذاری خطرپذیر جذب میکند. هوش مصنوعی حالتی را سپری میکند که ممکن است بیشتر جالب باشد تا مفید.

مرحله اول: از سال ۲۰۰۵ تا ۲۰۱۵ ایمنی هوش مصنوعی وارد مرحله اول میشود؛ که در آن گروه کوچکی از آینده پژوهان، فیلسوفان، فناوران و سرمایه گذاران خطرپذیر شروع به بحث در مورد چالش همسوسازی هوش ماشینی با نیازهای انسان میکنند. در اصل، هوش مصنوعی هنوز به اندازه کافی ملموس نیست و اکثر افراد عادی خطر را بیش از یک نگرانی سبک علمی - تخیلی احساس نمیکنند، چرا که فیلمها و رمانها معمولا واضحترین تجربهای هستند که هوش مصنوعی در سطح تحقیقاتی پیش میرود.

مرحله دوم: از ۲۰۱۵-۲۰۱۸ هوش مصنوعی به یک هدف بشردوستانه از منابع قابل توجه تبدیل میشود. پس از کنفرانس محوری هوش مصنوعی در پورتوریکو، سام آلتمن و ایلان ماسک بر ایمنی هوش مصنوعی متمرکز شدند و تلاش کردند حرکت به سمت جریان اصلیتر موضوع همسویی، هم با کمکهای بشردوستانه و هم با ایجاد آگاهی اجتماعی بیشتر دنبال کنند مسئلهای که آینده پژوهان اولیه مانند «الیزر یودکوفسکی» یا دانشگاهیان مانند «نیک بوستروم» نتوانستند به آن دست یابند.

مرحله سوم: از ۲۰۱۹-۲۰۲۳ انتقال به سمت هوش مصنوعی انتفاعی بهطور کامل آغاز میشود. هزینه قابل توجه آموزش و میزبانی هوش مصنوعی از طریق سرمایه گذاری شرکتی تامین میشود. از دیدگاه کسانی که به شیوهای غیر بازاری فکر میکنند، به نظر میرسد که این دوران بهعنوان دوران تسخیر است، که در آن هوش مصنوعی به مالکیت تبدیل میشود و تابع ساختارهای قانونی است که بهمنظور محافظت از سرمایه سهامداران بهجای محافظت از مردم در نظر گرفته شده است.

ترکیب منافع شرکتها و هوش مصنوعی چیزی فراتر از انگیزه بازار فراهم میکند: قانون و اجبارهای آن. در این مرحله، هوش مصنوعی به عنوان یک ابزار بسیار قدرتمند است، اما همچنان توسط انسانها هدایت میشود

مرحله چهارم: فراتر از ۲۰۲۳ جایی است که سناریوی بازار هوش مصنوعی واقعاً معنادار میشود. تا این مرحله، هوش مصنوعی مانند هر فناوری دیگری مانند پلاستیک، موتورهای احتراق داخلی یا تلفن بوده است، اگر واقعاً با خودمان صادق باشیم. اما ترکیب منافع شرکتها و هوش مصنوعی چیزی فراتر از انگیزه بازار فراهم میکند: قانون و اجبارهای آن. در این مرحله، هوش مصنوعی به عنوان یک ابزار بسیار قدرتمند است، اما همچنان توسط انسانها هدایت میشود به گونهای که آن را مانند دیگر ابزارهای به کار گرفته شده برای مزیت تجاری نسبی جلوه میدهد. ما انتظار داریم که این دوره تحت سلطه ادعاهای بهره وری و مزایا برای پذیرندگان اولیه باشد.

مرحله پنجم: این مرحله منحصر به فرد است و هنوز شروع نشده است. تا این زمان، ما نوعی فناوری را تجربه کردهایم که انسانها را از کارهای پست و طاقت فرسا رها میکند تا کارهایی را انجام دهند که ماشینهایی مانند کمباین و ماشین حساب نمیتوانند انجام دهند: فکرکردن. در این مرحله، ماشینهایی را میبینیم که هنوز نمیتوانند فکر کنند، و جایگزین نیروی کاری میشوند. هیچ مدل روشنی برای این مرحله وجود ندارد، زیرا ما به سادگی فرض کردهایم که انسانها برای تعقیب اهداف بالاتر آزاد خواهند بود. هنگامی که دستها به زور به کار گرفته نمیشدند، فرض بر این بود که ذهنها آزاد خواهند بود تا خلق کنند. در مرحله ۵ این امر از هم میپاشد، زیرا ماشینهای بی فکر شروع به رقابت با ذهن متفکر انسان در نیروی کار میکنند. از همه مهمتر، این ممکن است آخرین مرحله برای پیدا کردن یک راه فرار با تغییر قوانین برای هماهنگی بهتر با انگیزههای انسانی یا تنظیم هوش مصنوعی به گونهای با انگیزههای انسانی باشد.

مرحله ششم: در این مرحله، ماشینهای خودمختار کنترل سیستمها را بر عهده میگیرند. آنها محمولهها را هدایت میکنند، شبکههای برق، هواپیماهای بدون سرنشین خلبان و سایر وظایفی را که کنترل سیستمهای فیزیکی و مجازی حیاتی را در اختیار آنها قرار میدهد، کنترل میکنند. در حالی که انسانها هنوز هم میتوانند به صورت فیزیکی به چنین سیستمهایی متصل شوند، به تدریج توانایی قانونی برای انجام این کار در چارچوب قانون را از دست میدهند. زیرا دیگر نمیدانند وقتی آن سیستمها لغو میشوند چگونه آنچه را که ماشینها هدایت میکنند انجام دهند.

مرحله هفتم: این در نهایت جایی است که توانایی هوش مصنوعی برای فکر کردن به خود مشکل ساز میشود. همانطور که دیدیم هوش مصنوعی میتواند کد بنویسد، این توانایی را دارد که بهطور بالقوه به دنبال راههایی برای بازنویسی دستورها، توابع عینی و محدودیتهای خود باشد. هیچ کس نمیداند که آیا این در واقع امکان پذیر است یا خیر، اما اگر فرض ۱ برقرار باشد، البته نمیتوان از این احتمال به عنوان یک داستان علمی - تخیلی صرف یاد کرد.

هوش مصنوعی در پرتو تکنیکهای قانونی و اجبار قانونی

در زمینه هوش مصنوعی، قرار دادن تمام قدرت ماشینهای هوشمند در خدمت محدود ارزش سهام، نشان دهنده ترکیبی بین اجبار قانونی و هوش ماشینی است که هرگز با آن مواجه نشدهایم

بسیاری از ما بازارها را به عنوان آزادی انتخاب نحوه تخصیص منابع خود بین ارائه دهندگان متعدد کالاها و خدمات در نظر میگیریم. بازارهای کار نیز به ما این امکان را میدهند که انتخاب کنیم که مایل به ارائه خدمات خود برای جبران خسارت هستیم. اما در زمینه یک شرکت سهامی عام، وظیفه امانتداری مدیریت برای به حداکثر رساندن ارزش سهام سهامداران نشان دهنده آزادی بازار نیست، بلکه یک اجبار قانونی در بازار است؛ و در زمینه هوش مصنوعی، قرار دادن تمام قدرت ماشینهای هوشمند در خدمت محدود ارزش سهام، نشان دهنده ترکیبی بین اجبار قانونی و هوش ماشینی است که هرگز با آن مواجه نشدهایم. چه میشود اگر هوش مصنوعی بتواند با سرعتی بسیار سریعتر نقاط ضعف متعددی را بین هدف قانون و حرف پیاده سازی آن پیدا کند؟ به عنوان مثال، در سال ۲۰۰۵، پروفسور «برایان کالت»[۲۴]، شکافی را در قانون کشف کرد که پیگرد قانونی قتلهای مرتکب شده در بخشی از «پارک یلوستون»[۲۵] را که در داخل مرزهای «آیداهو»[۲۶] قرار دارد را غیرممکن میکرد. این به اصطلاح حفره منطقه مرگ تنها یک نمونه از راههایی است که دستورالعملهای انسانی متناقض اغلب به موقعیتهایی منجر میشوند که در آن رابطه ناقص بین حرف و قصد قانون ممکن است آنقدر ضعیف باشد که منجر به رفتار فاجعهباری شود که از نظر فنی قانونی است بدون اینکه از نظر اخلاقی مجاز باشد.

باید انتظار داشت که نوع جدیدی از تهدید ممکن است به سرعت بر اساس تعداد زیادی از فرصتها ناشی از حفرههایی که همگی حاوی کلمات وحشتناک «کاملا قانونی» هستند ایجاد شود. به عبارت دیگر هوش مصنوعی ممکن است از حفرههای قانونی برای افزایش ارزش سهام استفاده کند

سناریوی بازار هوش مصنوعی اساساً تابع این فرضیه است که اجبار قانون قویتر از تواناییهای آن برای محدود کردن بهره برداری فاجعه بار از امکانات است. هنگامی که به یک هوش مصنوعی فاقد احساس مسئولیت اخلاقی و به اندازه کافی قدرتمند دستور داده میشود که ارزش سهام را با حفظ قوانین فنی به حداکثر برساند، باید انتظار داشت که نوع جدیدی از تهدید ممکن است به سرعت بر اساس تعداد زیادی از فرصتها ناشی از حفرههایی که همگی حاوی کلمات وحشتناک «کاملا قانونی» هستند ایجاد شود. به عبارت دیگر هوش مصنوعی ممکن است از حفرههای قانونی برای افزایش ارزش سهام استفاده کند و این نوع جدیدی از تهدید است که تا کنون سابقه نداشته است.

آنچه در اینجا مهم است، درک این موضوع است که با خرید «اوپن آیای» توسط مایکروسافت، یک شرکت عمومی انتفاعی، نیاز بازار برای به حداکثر رساندن ارزش سهام را به یک هدف کلی پلتفرم یادگیری ماشین تزریق کرد. این، به طرز عجیبی، سناریوی پیشبینیشده گیره کاغذ است که «بوستروم»[۲۷] در سال ۲۰۰۳ هنگام مواجهه با موضوع «همگرایی ابزاری» توصیف کرد، جایی که همه هوشها هوشهای پایینتر را به عنوان موانعی برای خود میبینند: «فرض کنید ما یک هوش مصنوعی داریم که تنها هدف آن ساخت هرچه بیشتر گیره کاغذ است. هوش مصنوعی به سرعت متوجه خواهد شد که اگر انسان وجود نداشته باشد بسیار بهتر است، زیرا ممکن است انسان تصمیم بگیرد آن را خاموش کند. زیرا اگر انسانها این کار را انجام دهند، گیرههای کاغذ کمتری وجود خواهد داشت. همچنین، بدن انسان حاوی اتمهای زیادی است که میتوان آنها را به گیره کاغذ تبدیل کرد. آیندهای که هوش مصنوعی سعی میکند به سمت آن حرکت کند، آیندهای است که در آن تعداد زیادی گیره کاغذ وجود داشته باشد، اما هیچ انسانی وجود نداشته باشد. هوش مصنوعی کاری را انجام میدهد که فکر میکند خالقش از او خواسته، اما در بسیاری از زمینهها اشتباه خواهد داشت.» تا چندی پیش، چنین مثالهایی تخیلی به نظر میرسیدند، اما کسی میداند در آینده واقعاً چه اتفاقی میافتد؟

پینوشت

[۱]. Pia Malaney

[۲]. Institute for New Economic Thinking

[۳]. OpenAI

[۴]. machine learning

[۵]. Dall-E

[۶]. ChatGPT

[۷]. Nick Bostrom

[۸]. Eliezer Yudkowski

[۹]. Demis Hassabis

[۱۰]. Jaan Taalin

[۱۱]. Sam Altman

[۱۲].Bing

[۱۳]. LaMDA

[۱۴]. Bard

[۱۵]. Eliezer Yudkowsky

[۱۶]. Intelligence Research Institute (MIRI)

[۱۷]. Effective Altruism (EA)

[۱۸]. Sam Bankman Fried

[۱۹]. Artificial General Intelligence (AGI)

[۲۰]. Adam Smith

[۲۱]. The Wealth of Nations

[۲۲]. Peter Kropotkin

[۲۳]. E Pluribus Unum

[۲۴]. professor Brian Kalt

[۲۵]. Yellowstone

[۲۶]. Idaho

[۲۷]. Bostrom

/انتهای پیام/