گروه جامعه و اقتصاد «سدید»؛ «مایک توماس» [1] از پژوهشگران برجسته حوزه فناوری و صنعت نرمافزار، در یادداشتی که مجله تخصصی «Built In» آن را منتشر کرده است به موضوع خطراتی که در آینده، هوش مصنوعی ممکن است برای جوامع بشری در پی داشته باشد، پرداخته است. وی در این یادداشت از «جفری هینتون» از مدیران سابق گوگل و پدرخوانده هوش مصنوعی نقلقول میکند که «این خطر جدی وجود دارد که به زودی سیستمهای هوش مصنوعی از انسان هم هوشمندتر شده و کنترل همه چیز را به دست بگیرند. این فقط یک مسئله علمی - تخیلی نیست؛ بلکه یک مشکل جدی است که احتمالاً به زودی به وجود خواهد آمد و سیاستمداران باید به این فکر باشند که در مورد آن چه کاری انجام دهند.»

هشدار پدرخوانده هوش مصنوعی

همانطور که هوش مصنوعی پیچیدهتر و استفاده از آن گستردهتر میشود، صدای هشدار نسبت به خطرات بالقوه هوش مصنوعی نیز بلندتر میشود. «جفری هینتون» [2] که بهخاطر کار بنیادیاش روی یادگیری ماشینی و الگوریتمهای شبکه عصبی بهعنوان «پدرخوانده هوش مصنوعی» شناخته میشود، میگوید: «این چیزها میتوانند هوشمندتر از ما شوند و بتوانند تصمیم بگیرند که کنترل ما را به دست بگیرند و حالا ما باید نگران این باشیم که چگونه از این اتفاق جلوگیری کنیم». در سال ۲۰۲۳، «هینتون» موقعیت خود را در گوگل رها کرد تا بتواند درباره خطرات هوش مصنوعی صحبت کند. او خاطرنشان کرد که حتی از کار و پژوهش در این باره نیز پشیمان است.

کارگران یقه آبی که کارهای دستی و تکراری بیشتری انجام میدهند، به دلیل رواج هوش مصنوعی، کاهش دستمزدشان را تا ۷۰ درصد تجربه کردهاند؛ اما وضعیت کارگران یقه سفید تا حد زیادی دستنخورده باقی مانده است و حتی برخی از آنها از دستمزد بالاتری نیز برخوردار شدهاند.

این دانشمند مشهور علوم رایانه در نگرانیهای خود تنها نیست. «ایلان ماسک»، بنیانگذار «تسلا» و «اسپیس ایکس» [3]، به همراه بیش از ۱۰۰۰ مدیر دیگر حوزه فناوری، در نامهای سرگشاده در سال ۲۰۲۳ خواستار توقف آزمایشهای بزرگ در زمینه هوش مصنوعی شدند و اشاره کردند که این فناوری میتواند «خطرات عمیقی برای جامعه و بشریت ایجاد کند.» چه توسعه هوش مصنوعی در مشاغل خاص باشد، چه الگوریتمهای تبعیض جنسیتی و نژادی یا سلاحهای خودکار و خودمختار که بدون نظارت انسانی عمل میکنند؛ نارضایتی در چندین جبهه وجود دارد و ما هنوز در مراحل اولیه توانایی هوش مصنوعی هستیم. سؤالاتی در مورد اینکه چه کسی و برای چه اهدافی هوش مصنوعی را توسعه میدهد، درک نکات منفی بالقوه آن را ضروریتر میکند. در ادامه نگاهی دقیقتر به خطرات احتمالی هوش مصنوعی میاندازیم و چگونگی مدیریت خطرات آن را بررسی میکنیم.

- فقدان شفافیت و قابلیت توضیح هوش مصنوعی

درک مدلهای هوش مصنوعی و یادگیری عمیق، حتی برای کسانی که مستقیماً با این فناوری کار میکنند، دشوار است. این امر منجر به عدم شفافیت در مورد چگونگی و چرایی رسیدن هوش مصنوعی به نتایج خود میشود و عدم توضیح برای اینکه الگوریتمهای هوش مصنوعی از چه دادههایی استفاده میکنند، یا چرا ممکن است تصمیمات مغرضانه یا ناامن بگیرند نیز نگرانکننده است. این نگرانیها به استفاده از هوش مصنوعی منجر شدهاند، اما هنوز راه زیادی تا تبدیلشدن سیستمهای هوش مصنوعی به یک روش رایج وجود دارد.

- ازدستدادن شغل به دلیل رواج هوش مصنوعی

جایگزینی شغلی مبتنی بر هوش مصنوعی یک نگرانی مبرم است؛ زیرا این فناوری در صنایعی مانند بازاریابی، تولید و مراقبتهای بهداشتی هم پذیرفته شده است. به گفته شرکت «مککینزی» [4] تا سال ۲۰۳۰ میلادی ممکن است وظایفی که تا ۳۰ درصد از ساعات کاری کنونی در اقتصاد آمریکا را تشکیل میدهند، خودکار شوند و کارمندان به خصوص سیاهپوست و اسپانیایی در برابر این تغییرات آسیبپذیر هستند. شرکت بزرگ خدمات مالی و بانکداری «گلدمن ساکس» [5] حتی بیان میکند که ۳۰۰ میلیون شغل تماموقت ممکن است به دلیل رواج هوش مصنوعی از بین برود. همانطور که رباتهای هوش مصنوعی باهوشتر و ماهرتر میشوند، انجام وظایف نیز به انسانهای کمتری نیاز دارند و در حالی که تخمین زده میشود که هوش مصنوعی تا سال ۲۰۲۵، ۹۷ میلیون شغل جدید ایجاد کند، بسیاری از کارمندان، مهارتهای موردنیاز برای این نقشهای فنی را نخواهند داشت و اگر شرکتها نیروی کار خود را ارتقا ندهند، ممکن است عقب بمانند. این احتمال هم وجود دارد که شغل جدید به آموزش یا آموزش زیاد یا حتی استعدادهای درونی و مهارتهای بینفردی یا خلاقیت بالایی نیاز داشته باشد که ممکن است افراد آن را نداشته باشند.

حتی مشاغلی که به مدارک تحصیلات تکمیلی و آموزش اضافی پس از کالج نیاز دارند، از هوش مصنوعی مصون نیستند. همانطور که «کریس مسینا» [6]، استراتژیست فناوری اشاره کرده است، رشتههایی مانند حقوق و حسابداری برای تصاحب هوش مصنوعی آماده شدهاند. «مسینا» میگوید: «کاملاً محتمل است که برخی از این مشاغل از بین بروند. هوش مصنوعی در حال حاضر تأثیر قابلتوجهی بر پزشکی دارد. حقوق و حسابداری هم در رتبههای بعدی قرار دارند.» او در رابطه با حوزه حقوق میگوید: «به پیچیدگی قراردادها فکر کنید و به این نکته توجه کنید که برای ایجاد یک ساختار معاملاتی عالی چه چیزی لازم است. بسیاری از وکلا مطالب زیادی اعم از صدها یا هزاران صفحه داده و اسناد را مطالعه میکنند؛ بنابراین هوش مصنوعی این توانایی را دارد که بهترین قرارداد ممکن را برای نتیجهای که میخواهید تنظیم کند و به شما ارائه دهد؛ پس چرا شما باید به یک وکیل مراجعه کنید؟ لذا احتمالاً هوش جایگزین بسیاری از وکلای شرکتها خواهد شد».

- دستکاری اجتماعی از طریق الگوریتمهای هوش مصنوعی

دستکاری اجتماعی نیز بهعنوان یک خطر هوش مصنوعی محسوب میشود. این ترس به واقعیت تبدیل شده است، زیرا سیاستمداران برای ترویج دیدگاههای خود به پلتفرمها متکی هستند. یکی از نمونهها «فردیناند مارکوس جونیور» [7] است که از ارتش مجازی «تیکتاک» استفاده کرد تا آراء فیلیپینیهای جوان را در انتخابات ۲۰۲۲ فیلیپین به دست آورد. تیکتاک، تنها یک نمونه از پلتفرم رسانههای اجتماعی است که بر الگوریتمهای هوش مصنوعی متکی است. شکست «تیکتاک» در فیلترکردن محتوای مضر و نادرست، نگرانیها درباره توانایی این شبکه اجتماعی را برای محافظت از کاربرانش در برابر اطلاعات گمراهکننده افزایش داده است.

بیش از ۳۰ هزار نفر، از جمله محققان هوش مصنوعی و رباتیک در نامه سرگشادهای در سال ۲۰۱۶ با سرمایهگذاری در سلاحهای خودکار مجهز به هوش مصنوعی مخالفت کردند.

رسانهها و اخبار آنلاین در سایه تصاویر و ویدئوهای تولید شده توسط هوش مصنوعی، تغییردهندههای صدای با هوش مصنوعی و همچنین نفوذ آنها به حوزههای سیاسی و اجتماعی، وضعیت را تیرهتر کرده است. این فناوریها، ایجاد عکسها، فیلمها، کلیپهای صوتی واقعی یا جایگزینی تصویر یک چهره با چهره دیگر در یک تصویر یا ویدئو را آسان میکند. در نتیجه، بازیگران بداندیش، راه دیگری برای بهاشتراکگذاری اطلاعات نادرست و تبلیغات سوء دارند و سناریویی کابوسوار را ایجاد میکنند که در آن تشخیص بین اخبار معتبر و اشتباه تقریباً غیرممکن است.

«مارتین فورد» [8] پژوهشگر حوزه آیندهپژوهی میگوید: «هیچ کس نمیداند چه چیزی واقعی است و چه چیزی واقعی نیست؛ بنابراین این وضعیت به موقعیتی منجر میشود که به معنای واقعی کلمه نمیتوانید حتی به چشمها و گوشهای خود نیز اطمینان کنید. شما نمیتوانید به آنچه از نظر تاریخی بهترین شواهد ممکن را میتوان برای آن ارائه داد تکیه کنید. این یک مسئله بزرگ خواهد بود.»

- نظارت اجتماعی با فناوری هوش مصنوعی

«فورد» بر روی روشی که هوش مصنوعی بر حریم خصوصی و امنیت انسانها تأثیر منفی میگذارد، متمرکز است. نمونه بارز آن، استفاده چین از فناوری تشخیص چهره در ادارات، مدارس و مکانهای دیگر است. علاوه بر ردیابی حرکات یک فرد، دولت چین ممکن است بتواند دادههای کافی برای نظارت بر فعالیتها، روابط و دیدگاههای سیاسی یک فرد را نیز جمعآوری کند. مثال دیگر این است که ادارات پلیس آمریکا از الگوریتمهایی برای پیشبینی محل وقوع جرایم استفاده میکنند. مشکل این است که این الگوریتمها تحتتأثیر نرخهای دستگیری قرار میگیرند که به طور نامتناسبی بر جوامع سیاهپوست تأثیر میگذارد. سپس بر اساس برآوردهای هوش مصنوعی که مکانهای سیاهپوستنشین، جرمخیز نیز هستند، ادارات پلیس در این مکانها دو برابر میشوند و بر اساس همین برآورد سیاستگذاری میشود و در نتیجه این سؤال پیش میآید که آیا دموکراسیها میتوانند در برابر تبدیل هوش مصنوعی به یک سلاح استبدادی مقاومت کنند یا خیر؟

- عدم حفظ حریم خصوصی دادهها با استفاده از هوش مصنوعی

اگر با یک چت ربات هوش مصنوعی بازی کرده باشید یا یک فیلتر چهره هوش مصنوعی را به صورت آنلاین امتحان کرده باشید، دادههای شما جمعآوری میشود؛ اما این دادهها به کجا میرود و چگونه از آن استفاده میشود؟

صنعت مالی پذیرای مشارکت فناوری هوش مصنوعی در فرایندهای مالی و معاملات روزمره شده است. در نتیجه، معاملات الگوریتمی مبتنی بر هوش مصنوعی میتواند مسئول بحران مالی بعدی ما در بازارها باشد.

سیستمهای هوش مصنوعی اغلب دادههای شخصی را جمعآوری میکنند تا تجربههای کاربر را شخصیسازی کنند یا به آموزش مدلهای هوش مصنوعی مورداستفاده شما کمک کنند (مخصوصاً اگر ابزار هوش مصنوعی رایگان باشد). دادهها حتی ممکن است هنگام ارائه به یک سیستم هوش مصنوعی از سوی کاربران دیگر، امن در نظر گرفته نشوند. همین مسئله در سال جاری میلادی برای «ChatGPT» رخ داد. این سیستم هوش مصنوعی «به برخی از کاربران اجازه میداد تا عناوینی از تاریخچه چت یک کاربر فعال دیگر را ببینند». در حالی که قوانینی برای حفاظت از اطلاعات شخصی در برخی موارد در ایالات متحده وجود دارد، هیچ قانون فدرال صریحی وجود ندارد که از شهروندان در برابر آسیبهای حریم خصوصی دادهها توسط هوش مصنوعی محافظت کند.

- تعصبات ناشی از هوش مصنوعی

اشکال مختلف سوگیری هوش مصنوعی نیز مضر هستند. «اولگا روساکوفسکی» [9] استاد علوم رایانه دانشگاه «پرینستون»، در گفتگو با نیویورکتایمز میگوید: «تعصب ناشی از هوش مصنوعی فراتر از جنسیت و نژاد است. علاوه بر دادهها و سوگیری الگوریتمی - که دومی میتواند اولی را تقویت کند - هوش مصنوعی توسط انسانها توسعه یافته است و انسانها ذاتاً سوگیری دارند.»

روساکوفسکی میگوید: «پژوهشگران هوش مصنوعی در درجه اول انسانهایی هستند که از جمعیتشناسی نژادی خاصی میآیند و در مناطق اقتصادی - اجتماعی بالا بزرگ شدهاند و در درجه اول افرادی بدون معلولیت هستند. ما یک جمعیت نسبتاً همگن هستیم، بنابراین تفکر گسترده در مورد مسائل جهانی یک چالش است.»

تجربیات محدود سازندگان هوش مصنوعی ممکن است توضیح دهد که چرا هوش مصنوعی تشخیص گفتار، اغلب در درک گویشها و لهجههای خاص شکست میخورد، یا چرا شرکتها نمیتوانند عواقب جعل هویت شخصیتهای بدنام در تاریخ بشر را در نظر بگیرند. توسعهدهندگان و کسبوکارها باید دقت بیشتری به خرج دهند تا از بازآفرینی سوگیریها و پیشداوریهای قدرتمندی که جمعیت اقلیتها را در معرض خطر قرار میدهد، اجتناب کنند.

- نابرابری اجتماعی - اقتصادی در نتیجه هوش مصنوعی

اگر شرکتها از تصدیق سوگیریهای ذاتی در الگوریتمهای هوش مصنوعی خودداری کنند، ممکن است ابتکارات DEI (تنوع، عدالت و فراگیری) خود را از طریق استخدام مبتنی بر هوش مصنوعی به خطر بیندازند. این ایده که هوش مصنوعی میتواند ویژگیهای یک نامزد را از طریق تجزیه و تحلیلهای چهره و صدا اندازهگیری کند، همچنان با تعصبات نژادی آلوده است و همان شیوههای استخدام تبعیضآمیز را بازتولید میکند که مشاغل ادعا میکنند آن را حذف کردهاند. گسترش نابرابریهای اجتماعی - اقتصادی، به دلیل ازدستدادن شغل مبتنی بر رواج هوش مصنوعی، یکی دیگر از دلایل نگرانی است که سوگیریهای طبقاتی در مورد نحوه بهکارگیری هوش مصنوعی را آشکار میکند. کارگران یقه آبی که کارهای دستی و تکراری بیشتری انجام میدهند به دلیل جایگزینی با هوش مصنوعی، کاهش دستمزدشان را تا ۷۰ درصد تجربه کردهاند. در همین حال، وضعیت کارگران یقه سفید تا حد زیادی دستنخورده باقی مانده و حتی برخی از آنها از دستمزد بالاتری نیز برخوردار شدهاند. ادعاهای فراگیر مبنی بر اینکه هوش مصنوعی به نوعی بر مرزهای اجتماعی غلبه کرده یا مشاغل بیشتری ایجاد کرده است، نمیتواند تصویر کاملی از اثرات آن ارائه دهد. درنظرگرفتن تفاوتها بر اساس نژاد، طبقه و سایر دستهبندیها بسیار مهم است. در غیر این صورت، تشخیص اینکه هوش مصنوعی و اتوماسیون چگونه به ضرر افراد و گروههای خاص و به نفع دیگران است، دشوارتر میشود.

- تضعیف اخلاق و حسننیت توسط هوش مصنوعی

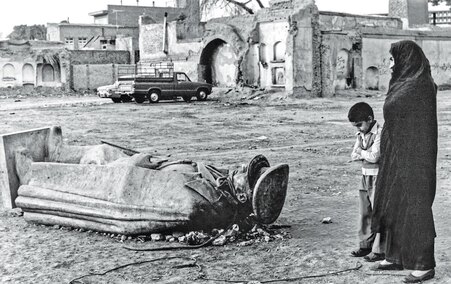

در کنار فناوران، روزنامهنگاران و شخصیتهای سیاسی، حتی رهبران مذهبی نیز زنگ خطر احتمالی اجتماعی - اقتصادی هوش مصنوعی را به صدا درآوردهاند. پاپ فرانسیس در نشست واتیکان در سال ۲۰۱۹ با عنوان «خیر مشترک در عصر دیجیتال» نسبت به توانایی هوش مصنوعی برای «انتشار عقاید متعصبانه و دادههای نادرست» هشدار داد و بر عواقب گسترده اجازه توسعه این فناوری بدون نظارت یا محدودیت مناسب تأکید کرد. وی گفت «اگر پیشرفت به اصطلاح تکنولوژیکی بشر به دشمن خیر مشترک تبدیل شود، این امر منجر به بازگشتی تأسفبار به نوعی توحش میشود که توسط قانون قویترینها دیکته شده است.»

در آمریکا هیچ قانون فدرال صریحی وجود ندارد که از شهروندان در برابر آسیبهای نقض حریم خصوصی دادهها توسط هوش مصنوعی محافظت کند.

ظهور سریع ابزارهای مولد هوش مصنوعی مانند «ChatGPT» و «Bard» به نگرانیهای بیشتر در این زمینه دامن میزند. بسیاری از کاربران از این فناوری برای رهایی از تکالیف نوشتاری استفاده کردهاند که یکپارچگی و خلاقیت تحصیلی را تهدید میکند. برخی از این بیم دارند که مهم نیست چه تعداد از شخصیتهای قدرتمند به خطرات هوش مصنوعی اشاره میکنند، چرا که اگر راهی برای دستیابی به درآمد بیشتر وجود داشته باشد، همچنان توسعه هوش مصنوعی ادامه خواهد یافت. «کریس مسینا»، استراتژیست حوزه فناوری میگوید: «ذهنیت این است که اگر بتوانیم این کار را انجام دهیم، باید آن را امتحان کنیم؛ بعد ببینیم چه اتفاقی میافتد و اگر بتوانیم از آن پول دربیاوریم، آن را انجام خواهیم داد. اما این منحصر به فناوری نیست. این اتفاق همواره در حال رخدادن است.»

- سلاحهای خودگردان که توسط هوش مصنوعی کار میکنند

همانطور که اغلب اتفاق میافتد، پیشرفتهای تکنولوژیک برای اهداف جنگی به کار گرفته میشوند. وقتی صحبت از هوش مصنوعی به میان میآید، برخی مشتاق هستند قبل از اینکه خیلی دیر شود، کاری در مورد آن انجام دهند؛ بیش از ۳۰ هزار نفر از جمله محققان هوش مصنوعی و رباتیک در نامهای سرگشاده در سال ۲۰۱۶، با سرمایهگذاری در سلاحهای خودمختار مجهز به هوش مصنوعی مخالفت کردند. آنها نوشتند: «سؤال کلیدی امروز برای بشریت این است که آیا باید یک مسابقه تسلیحاتی جهانی هوش مصنوعی را آغاز کرد یا از شروع آن جلوگیری نمود؟ اگر هر قدرت بزرگ نظامی با توسعه سلاح هوش مصنوعی پیش برود، مسابقه تسلیحاتی جهانی عملاً اجتنابناپذیر خواهد بود و نقطه پایانی این مسیر تکنولوژیک واضح است: سلاحهای خودمختار به کلاشینکفهای فردا تبدیل خواهند شد.»

شرکت بزرگ خدمات مالی و بانکداری «گلدمن ساکس» میگوید ۳۰۰ میلیون شغل تماموقت ممکن است به دلیل رواج هوش مصنوعی از بین برود.

این پیشبینی در قالب سیستم «سلاحهای خودکار لترال» [10] به ثمر نشسته است که اهداف را بهتنهایی و در عین حال با رعایت برخی مقررات پیدا و نابود میکنند. به دلیل گسترش سلاحهای قدرتمند و پیچیده، برخی از قدرتمندترین کشورهای جهان تسلیم نگرانیها شدهاند. بسیاری از این سلاحهای جدید خطرات عمدهای را برای غیرنظامیان در زمین ایجاد میکنند، اما این خطر زمانی تشدید میشود که سلاحهای خودمختار به دست افراد اشتباه بیفتند. هکرها بر انواع مختلفی از حملات سایبری تسلط پیدا کردهاند، بنابراین تصور نفوذ یک عامل مخرب به سلاحهای خودمختار که منجر به یک «آرماگدون» شود، دشوار نیست. اگر رقابتهای سیاسی و تمایلات جنگطلبانه کنترل نشوند، هوش مصنوعی میتواند با بدترین نیات به کار گرفته شود.

- بحرانهای مالی ناشی از الگوریتمهای هوش مصنوعی

صنعت مالی نیز پذیرای مشارکت فناوری هوش مصنوعی در فرایندهای مالی و معاملات روزمره شده است. در نتیجه، معاملات الگوریتمی میتواند مسئول بحران مالی بعدی ما در بازارها باشد. در حالی که الگوریتمهای هوش مصنوعی تحتتأثیر قضاوت یا احساسات انسان قرار نمیگیرند، اما زمینهها، ارتباط متقابل بازارها و عواملی مانند اعتماد و ترس انسان را نیز در نظر نمیگیرند. اتفاقاتی مانند «سقوط سریع» [11] سال ۲۰۱۰ و سقوط ناگهانی شرکت خدمات مالی «نایت کاپیتال» [12] آمریکا یادآور اتفاقاتی هستند که ممکن است در زمان اجرای الگوریتمهای تجاری رخ دهد. این بدان معنا نیست که هوش مصنوعی چیزی برای ارائه به دنیای مالی ندارد. در واقع، الگوریتمهای هوش مصنوعی میتوانند به سرمایهگذاران کمک کنند تا تصمیمات هوشمندانه و آگاهانهتری در بازار بگیرند. اما سازمانهای مالی باید مطمئن شوند که الگوریتمهای هوش مصنوعی و نحوه تصمیمگیری آن الگوریتمها را درک میکنند. شرکتها باید قبل از معرفی این فناوری برای جلوگیری از ایجاد ترس در بین سرمایهگذاران و ایجاد هرج و مرج مالی، در نظر بگیرند که آیا هوش مصنوعی اعتماد آنها را بالا میبرد یا کاهش میدهد.

- از دست دادن نفوذ انسانی

اتکای بیش از حد به فناوری هوش مصنوعی میتواند منجر به از بین رفتن نفوذ انسانی و فقدان عملکرد انسان در برخی از بخشهای جامعه شود. به عنوان مثال، استفاده از هوش مصنوعی در مراقبتهای بهداشتی میتواند منجر به کاهش همدلی انسانی شود. همچنین استفاده از هوش مصنوعی مولد برای تلاشهای خلاقانه میتواند خلاقیت و بیان احساس انسانی را کاهش دهد. تعامل بیش از حد با سیستمهای هوش مصنوعی حتی میتواند باعث کاهش مهارتهای ارتباطی و اجتماعی با همتایان شود. بنابراین در حالی که هوش مصنوعی میتواند برای خودکار کردن کارهای روزانه بسیار مفید باشد، برخی این سؤال را مطرح میکنند که آیا ممکن است هوش، تواناییها و نیاز کلی انسان به جامعه را کاهش دهد یا خیر؟

- هوش مصنوعی خودآگاه غیرقابلکنترل

همچنین این نگرانی وجود دارد که هوش مصنوعی آنقدر سریع پیشرفت کند که هوشیار شود و فراتر از کنترل انسان و احتمالاً به روشی مخرب عمل کند. گزارشهای ادعایی از این احساس قبلاً رخ داده است. یکی از مهندسان سابق گوگل در این زمینه اظهار داشت: «ربات چت هوش مصنوعی «LaMDA» حساس بوده و دقیقاً مانند یک شخص با او صحبت میکند.» از آنجا که نقاط عطف بزرگ بعدی هوش مصنوعی شامل ساخت سیستمهایی با هوش عمومی مصنوعی و در نهایت ابر هوش مصنوعی است، درخواستها برای توقف کامل این پیشرفتها همچنان در حال افزایش است.

چگونه خطرات هوش مصنوعی را کاهش دهیم

هوش مصنوعی همچنان دارای مزایای بیشماری مانند سازماندهی دادههای سلامتی و تقویت خودروهای خودران است؛ با این حال، برخی استدلال میکنند که برای استفاده حداکثری از این فناوری پیشرو، مقررات زیادی لازم است. «جفری هینتون» از مدیران سابق گوگل و پدرخوانده هوش مصنوعی میگوید: «این خطر جدی وجود دارد که به زودی سیستمهای هوش مصنوعی از ما هوشمندتر شوند و این چیزها ممکن است انگیزههای بدی پیدا کنند و کنترل ما را در دست بگیرند. این فقط یک مسئله علمی - تخیلی نیست. این یک مشکل جدی است که احتمالاً به زودی به وجود خواهد آمد و سیاستمداران باید به فکر این باشند که اکنون در مورد آن چه کاری میتوانند انجام دهند»

تدوین مقررات قانونی

تنظیم مقررات در زمینه هوش مصنوعی تمرکز اصلی دهها کشور بوده است و اکنون ایالات متحده و اتحادیه اروپا در حال ایجاد اقدامات واضحتر برای مدیریت پیچیدگیهای روزافزون هوش مصنوعی هستند. جو بایدن - رئیسجمهور آمریکا - در سال ۲۰۲۳ فرمان اجرایی صادر کرد که در آن آژانسهای فدرال را ملزم به تدوین قوانین و دستورالعملهای جدید برای ایمنی و امنیت هوش مصنوعی کرد. اگرچه این بدان معناست که برخی از فناوریهای هوش مصنوعی در نهایت میتوانند ممنوع شوند، اما مانع از تحقیقات در این زمینه توسط کشورها نمیشود.

ایجاد استانداردهای هوش مصنوعی سازمانی

از نظر «مارتین فورد» - پژوهشگر حوزه آیندهپژوهی - حفظ روحیه آزمایش، حیاتی است، زیرا وی معتقد است هوش مصنوعی برای کشورهایی که به دنبال نوآوری و همگام با بقیه جهان هستند ضروری است. وی میگوید: «شما نحوه استفاده از هوش مصنوعی را تنظیم میکنید، اما پیشرفت در فناوری پایه را متوقف نمیکنید. فکر میکنم این کار اشتباه و بالقوه خطرناک است. ما تصمیم میگیریم که کجا هوش مصنوعی میخواهیم و کجا نمیخواهیم. کشورهای مختلف انتخابهای متفاوتی درباره جایی که قابلقبول باشد یا نباشد، خواهند داشت.»

نکته کلیدی این است که تصمیم بگیرید چگونه هوش مصنوعی را به شیوهای اخلاقی به کار ببرید. در سطح شرکتی، گامهای زیادی وجود دارد که کسبوکارها میتوانند هنگام ادغام هوش مصنوعی در عملیاتهای خود بردارند. سازمانها میتوانند فرایندهایی را برای نظارت بر الگوریتمها، گردآوری دادههای با کیفیت بالا و توضیح یافته توسط الگوریتمهای هوش مصنوعی توسعه دهند. رهبران حتی میتوانند هوش مصنوعی را بخشی از فرهنگ شرکت خود کنند و استانداردهایی را برای تعیین فناوریهای قابلقبول هوش مصنوعی ایجاد کنند.

هدایت فناوری با دیدگاههای علومانسانی

به هر حال وقتی صحبت از جامعه بهعنوان یک کل میشود، باید فشار بیشتری در فناوری برای پذیرش دیدگاههای مختلف علومانسانی وجود داشته باشد. محققان هوش مصنوعی دانشگاه استنفورد در یک پست وبلاگی در سال ۲۰۱۹ این بحث را مطرح کرده و خواستار رهبری ملی و جهانی در تنظیم هوش مصنوعی شدهاند: «سازندگان هوش مصنوعی باید به دنبال بینشها، تجربیات و نگرانیهای مردم در میان قومیتها، جنسیتها، فرهنگها و گروههای اجتماعی - اقتصادی و همچنین حوزههای دیگر مانند اقتصاد، حقوق، پزشکی، فلسفه، تاریخ، جامعهشناسی، ارتباطات، تعامل انسان و کامپیوتر، روانشناسی و مطالعات علم و فناوری (STS)باشند»

ایجاد تعادل بین نوآوری در فناوری پیشرفته و تفکر انسانمحور، روشی ایدهآل برای تولید فناوری هوش مصنوعی مسئولانه بوده و اطمینان از اینکه آینده هوش مصنوعی برای نسل بعدی مضر نیست، امیدوارکننده است. خطرات هوش مصنوعی همیشه باید موضوع بحث باشد، بنابراین رهبران میتوانند راههایی برای استفاده از این فناوری برای اهداف عالی پیدا کنند.

[1] . Mike Thomas

[2] . Geoffrey Hinton

[3] . Space Exploration

[4] . McKinsey

[5] . Goldman Sachs

[6] . Chris Messina

[7] . Ferdinand Marcos, Jr

[8] . Martin Ford

[9] . Olga Russakovsky

[10] . Lethal Autonomous Weapon

[11] . Flash Crash

[12] . Knight Capital Flash Crash

/انتهای پیام/