گروه جامعه و اقتصاد «سدید»؛ «لن برمر» [1] - پژوهشگر و نویسنده - و «مصطفی سلیمان» [2] - مدیرعامل و یکی از بنیانگذاران استارتاپ هوش مصنوعی «Inflection» - در یادداشتی که مجله آمریکایی «Foreign Affairs» آن را منتشر کرده است، به موضوع مدیریت و نظارت بر هوش مصنوعی پرداختهاند. آنها هشدار میدهند که تا دیر نشده باید اجماعی جهانی برای مدیرت و نظارت بر هوش مصنوعی در سطح جهان شکل بگیرد. به گفته این دو، جهان تاکنون با چالشی خطرناکتر از هوش مصنوعی درگیر نبوده و مدیریت و نظارت بر آن نیازمند یک اجماع جهانی در سطح دولتها، شرکتهای فناوری و تمامی نهادها و افراد مرتبط با این حوزه است. ناگفته پیداست که این یادداشت اهمیت و ضرورت سرمایهگذاری در حوزه هوش مصنوعی بهعنوان یکی از مؤلفههای قدرت آینده را نیز نشان میدهد. دولتهایی که در این حوزه عقب بمانند طی سالهای آینده چالشهای چندوجهی سیاسی، اقتصادی، امنیتی و اجتماعی گستردهای را تجربه خواهند کرد.

جهان در سال ۲۰۳۵

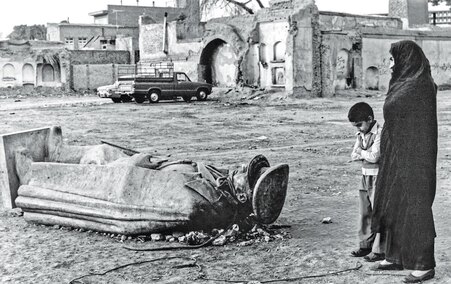

اکنون سال ۲۰۳۵ است و هوش مصنوعی در همه جا حضور دارد! سیستمهای هوش مصنوعی، بیمارستانها و خطوط هوایی را اداره میکنند و در دادگاهها بهعنوان وکیل با یکدیگر وارد مجادله حقوقی میشوند. بهرهوری به سطوح بیسابقهای رسیده است و تعداد بیشماری کسبوکار که قبلاً غیرقابلتصور بود، با سرعتی بیسابقه افزایش یافتهاند و پیشرفتهای عظیمی در رفاه ایجاد کردهاند. محصولات جدید، درمانها و ابتکارات بهصورت روزانه وارد بازار میشوند؛ زیرا علم و تکنولوژی با سرعت فوقالعادهای در حال رشد و توسعه است. با این حال، جهان هم غیرقابلپیشبینیتر و هم شکنندهتر شده است؛ زیرا تروریستها راههای جدیدی را برای تهدید جوامع با سلاحهای سایبری هوشمند و در حال تکامل پیدا کردهاند و کارگران یقهسفید نیز به دلیل استفاده گسترده از هوش مصنوعی، همگی شغل خود را از دست دادهاند.

سناریوی که ذکر شد، همین یک سال پیش کاملاً تخیلی به نظر میرسید؛ اما امروز وقوع این سناریو تقریباً اجتنابناپذیر به نظر میرسد. سیستمهای هوش مصنوعی مولد اکنون قادرند به نحو واضحتر و قانعکنندهتری از اکثر انسانها بنویسند و تصاویر، هنر و حتی کدهای کامپیوتری را بر اساس سامانههای زبانی ساده تولید کنند. هوش مصنوعی پیشرفته، تنها نوک کوه یخ است. ورود آن به عرصه، نشاندهنده لحظه یک انفجار بزرگ است؛ آغاز یک انقلاب تکنولوژیکی در حال تغییر جهان که سیاست، اقتصاد و جوامع را از نو بازسازی خواهد کرد. مانند امواج فناوری در گذشته، هوش مصنوعی نیز فرصتها و چالشهای عظیمی را پیش پای جوامع قرار میدهد. اما بر خلاف موجهای قبلی، هوش مصنوعی تغییری مهیب در ساختار و موازنه قدرت جهانی ایجاد خواهد کرد؛ زیرا وضعیت دولت - ملتها بهعنوان بازیگران اصلی ژئوپلیتیک جهان با قدرتگرفتن هوش مصنوعی تهدید میشود.

دولتها به دلیل پیچیدگی و سرعت بسیار بالای توسعه هوش مصنوعی از روند تحولات عقب ماندهاند و قادر به نظارت و مدیریت آن نیستند.

خالقان هوش مصنوعی چه بپذیرند و چه نپذیرند، جزء بازیگران ژئوپلیتیک هستند و حاکمیت آنها بر هوش مصنوعی، نظم نوظهور «تکنوپولار» [3] را بیشتر تثبیت میکند. نظمی که در آن شرکتهای فناوری از نوعی قدرت در حوزه خود استفاده میکنند که زمانی تنها به دولت - ملتها اختصاص داشت. در دهه گذشته، شرکتهای بزرگ فناوری عملاً به بازیگران مستقل و خودمختاری در حوزههای دیجیتالی که ایجاد کردهاند، تبدیل شدهاند. هوش مصنوعی این روند را تسریع میکند و آن را بسیار فراتر از دنیای دیجیتال گسترش میدهد. پیچیدگی فناوری و سرعت پیشرفت آن، وضع قوانین مرتبط را برای دولتها تقریباً غیرممکن میکند. اگر دولتها هرچه سریعتر این عقبماندگی را جبران نکنند، ممکن است دیگر هرگز نتوانند خود را با این تحولات تطبیق دهند.

خوشبختانه سیاستگذاران در سراسر جهان نسبت به چالشهای ناشی از هوش مصنوعی کمکم در حال آگاه شدن هستند. در ماه می ۲۰۲۳ میلادی، اعضای گروه هفت کشور صنعتی «فرایند هیروشیمای هوش مصنوعی» [4]را راهاندازی کردند؛ انجمنی که به هماهنگکردن حکمرانی هوش مصنوعی اختصاص داشت. در ماه ژوئن ۲۰۲۳ پارلمان اروپا پیشنویس قانون هوش مصنوعی اتحادیه اروپا را تصویب کرد که این اولین تلاش جامع اتحادیه اروپا برای ایجاد تدابیر حفاظتی در اطراف صنعت هوش مصنوعی محسوب میشود و نهایتاً در ماه ژوئیه ۲۰۲۳ «آنتونیو گوترش» - دبیرکل سازمان ملل متحد - خواستار ایجاد یک نهاد نظارتی جهانی بر هوش مصنوعی شد. در همین حال، در آمریکا نیز سیاستمداران در هر دو حزب دموکرات و جمهوریخواه، خواستار اقدامات نظارتی هستند. اما در زمینه ایجاد سازوکارهای نظارتی بسیاری با «تد کروز» - سناتور جمهوریخواه ایالت تگزاس - که گفته است «کنگره نمیداند دارد چه میکند»، موافقاند.

متأسفانه، بسیاری از بحثها در مورد حکمرانی هوش مصنوعی همچنان در یک چرخه نادرست و خطرناک گیر کرده است؛ آیا باید از هوش مصنوعی برای گسترش قدرت ملی استفاده کرد یا به دلیل خطرات احتمالی، استفاده از آن را باید محدود کرد. حتی کسانی که به طور دقیق مشکل را تشخیص میدهند، سعی میکنند معضل ایجاد شده درباره هوش مصنوعی را در چارچوبهای حاکمیتی موجود یا سابق حل کنند. با این حال و در حال حاضر هوش مصنوعی مفاهیم سنتی قدرت ژئوپلیتیک را تغییر داده است و نمیتوان مانند فناوریهای قبلی آن را مدیریت کرد.

چالش در این زمینه به طراحی چارچوب حکومتی جدید متناسب با این فناوری منحصربهفرد برمیگردد. اگر قرار است حکمرانی جهانی هوش مصنوعی ممکن شود، سیستم بینالمللی باید از مفاهیم سنتی حاکمیت عبور کرده و از شرکتهای فناوری استقبال کند. شرکتهای فناوری اگر چه ممکن است مشروعیت خود را از یک قرارداد اجتماعی، دموکراسی یا ارائه کالاهای عمومی به دست نیاورند، اما بدون آنها حکمرانی مؤثر هوش مصنوعی شانسی برای موفقیت نخواهد داشت. این نمونهای از چگونگی نیاز جامعه بینالمللی به بازنگری در مفروضات اساسی در مورد نظم ژئوپلیتیک است..

اما مسئله تنها این نیست. چالشی عجیب و فوری بهاندازه هوش مصنوعی نیازمند یک راهحل اصلی است. قبل از اینکه سیاستگذاران بتوانند ساختار نظارتی مناسب را تدوین کنند، باید بر روی اصول اساسی برای نحوه اداره هوش مصنوعی به توافق برسند. برای شروع، هر چارچوب حکومتی در زمینه هوش مصنوعی نیازمند احتیاط، چابکی، جامعیت، نفوذناپذیری و هدفمندی خواهد بود. با تکیه بر این اصول، سیاستگذاران باید حداقل سه رژیم نظارتی همپوشان ایجاد کنند: اول، حقیقتیابی و مشاوره به دولتها در مورد خطرات ناشی از هوش مصنوعی. دوم، تلاش برای جلوگیری از یک مسابقه تسلیحاتی همهجانبه بین آنها و سوم، مدیریت نیروهای مخرب ناشی از فناوری هوش مصنوعی که جهان تا کنون نظیر آن را ندیده است. چه بخواهیم چه نخواهیم، ۲۰۳۵ در راه است. این که جهان آینده با پیشرفتهای مثبت ناشی از هوش مصنوعی یا اختلالات منفی ناشی از آن تعریف میشود، به این بستگی به دارد که سیاستگذاران در حال حاضر در رابطه با آن کدام خطمشی را اتخاذ میکنند.

سریعتر، عالیتر، قویتر

هوش مصنوعی متفاوت از سایر فناوریها است و تأثیر آن بر قدرت نیز متفاوت است. ماهیت متفاوت هوش مصنوعی فقط چالشهای سیاستی را ایجاد نمیکند، بلکه ماهیت فوق تکاملی آن نیز حل آن چالشها را بهتدریج سختتر میکند و این پارادوکس قدرت هوش مصنوعی است.

سرعت پیشرفت هوش مصنوعی خیرهکننده است. «قانون مور» [5]را در نظر بگیرید که با موفقیت دوبرابر شدن قدرت محاسباتی را هر دو سال یکبار پیشبینی کرده است؛ موج جدید هوش مصنوعی باعث میشود که این میزان پیشرفت عجیب و خیرهکننده به نظر برسد. هنگامی که مؤسسه پژوهشی هوش مصنوعی «OpenAI» اولین مدل زبانی خود را به نام «GPT-1» در سال ۲۰۱۸ راهاندازی کرد، دارای ۱۱۷ میلیون پارامتر بود که این نشان از پیچیدگی آن سیستم داشت. پنج سال بعد، اینطور تصور میشود که نسل چهارم این مدل یعنی «GPT-4»، بیش از یک تریلیون پارامتر داشته باشد. میزان محاسباتی که برای آموزش قویترین مدلهای هوش مصنوعی استفاده میشود، در ۱۰ سال گذشته هر سال ۱۰ برابر افزایش یافته است؛ بهعبارتدیگر، پیشرفتهترین مدلهای هوش مصنوعی امروزی که بهعنوان مدلهای «پیشرو» نیز شناخته میشوند، نسبت به مدلهای پیشرفته یک دهه پیش، از پنج میلیارد قدرت محاسباتی بیشتر برخوردار هستند. پردازشی که زمانی هفتهها طول میکشید، اکنون در چند ثانیه انجام میشود. مدلهایی که میتوانند دهها تریلیون پارامتر را مدیریت کنند، در چند سال آینده عرضه میشوند. مدلهای «مقیاس مغز» با بیش از ۱۰۰ تریلیون پارامتر - تقریباً معادل تعداد سیناپسها[6] در مغز انسان - ظرف پنج سال قابلاجرا خواهند بود.

با هر پیشرفت جدیدی در زمینه هوش مصنوعی، قابلیتهای غیرمنتظرهای نیز ظاهر میشود. کمتر کسی پیشبینی کرد که کار بر روی متن خام قادر است به مدلهای زبانهای بزرگ این امکان را بدهد که جملات روان، نوآورانه و حتی خلاقانه تولید کنند. کسی انتظار نداشت که مدلهای زبانی بتوانند موسیقی بسازند یا مشکلات علمی را حل کنند، اما برخی از این مدلها اکنون قادر به انجام این کارها هستند. بهزودی توسعهدهندگان هوش مصنوعی احتمالاً در ایجاد سیستمهایی با قابلیتهای خودارتقایی موفق خواهند شد؛ این مقطعی حیاتی در مسیر این فناوری است که همه را شگفتزده خواهد کرد.

بدون حضور شرکتهای فناوری، حکمرانی مؤثر هوش مصنوعی شانسی برای موفقیت نخواهد داشت.

مدلهای هوش مصنوعی با صرف کمترین زمان و انرژی، کار بیشتری انجام میدهند و بازدهی بالاتری دارند. قابلیتهای پیشرفته دیروز در سیستمهای کوچکتر، ارزانتر و در دسترستر امروز اجرا میشوند. تنها سه سال پس از انتشار «GPT-3» از سوی مؤسسه پژوهشی هوش مصنوعی «OpenAI»، تیمهای این مؤسسه مدلهایی با همان سطح کارایی را ایجاد کردند که کمتر از یک شصتم اندازه قبلی است و بهصورت کاملاً رایگان و در اینترنت برای همه در دسترس است. مدلهای «زبان بزرگ» [7] آینده، احتمالاً این مسیر کارآمدی را دنبال خواهند کرد و تنها دو یا سه سال پس از صرف صدها میلیون دلار از سوی آزمایشگاههای پیشرو هوش مصنوعی برای توسعه آنها در دسترس همه خواهند بود.

نسبت به داراییهای منقول و مادی و همانند هر نرمافزار دیگری، کپی و بهاشتراکگذاری یا سرقت الگوریتمهای هوش مصنوعی بسیار آسانتر و ارزانتر است. خطر تکثیر، آشکار است. بهعنوانمثال، مدل قدرتمند زبان بزرگ، تولیدی شرک متا تحت عنوان «Llama-1» چند روز پس از عرضه، به اینترنت درز کرد. اگرچه قویترین مدلها هنوز برای کارکردن به سختافزار پیچیدهای نیاز دارند، نسخههای متوسط میتوانند روی رایانههایی اجرا شوند که میتوان آنها را با قیمت چند دلار در ساعت اجاره کرد. بهزودی چنین مدلهایی بر روی گوشیهای هوشمند اجرا خواهند شد. هیچ فناوری دیگری مثل هوش مصنوعی تاکنون به این اندازه و با این قدرت و سرعت در دسترس نبوده است.

هوش مصنوعی همچنین با فناوریهای قدیمیتر از این جهت متفاوت است که تقریباً میتوان آن را تحت عنوان کاربردهای دوگانه نظامی و غیرنظامی توصیف کرد. بسیاری از سیستمهای هوش مصنوعی ذاتاً کلی و فراگیر هستند و در واقع، عمومیت و فراگیری، هدف اصلی بسیاری از شرکتهای هوش مصنوعی است. این شرکتها میخواهند برنامههای کاربردیشان به بیشترین تعداد ممکن از مردم کمک کند؛ اما همان سیستمهایی که ماشینها را هدایت میکنند، میتوانند تانکها را نیز هدایت کنند. یک برنامه کاربردی هوش مصنوعی که برای تشخیص بیماریها ساخته شده است، ممکن است بتواند برنامه جدیدی برای ایجاد یک سلاح نیز بنویسد. مرزهای بین کاربردهای غیرنظامی امن و نظامی مخرب از هوش مصنوعی، ذاتاً مبهم است و همین تا حدی توضیح میدهد که چرا آمریکا صادرات پیشرفتهترین نیمههادیها را به چین محدود کرده است.

ماهیت فوق تکاملی هوش مصنوعی، چالشهایی را ایجاد و حل این چالشها را بهتدریج سخت میکند و این پارادوکس قدرت هوش مصنوعی است.

همه اینها در یک پهنه جهانی انجام میشود؛ مدلهای هوش مصنوعی پس از انتشار، میتوانند در همه جهان گسترش پیدا کنند و صرفاً یک مدل بدخیم برای ویران کردن در مقیاس گسترده لازم است. به همین دلیل، تنظیم و مدیریت هوش مصنوعی نمیتواند بهصورت مجزا انجام شود و از این رو، اگر در برخی از کشورها هوش مصنوعی مهار، کنترل و تنظیم نشود در دیگر کشورها تنظیم یا کنترل آن ارزشی نخواهد داشت. از آنجایی که هوش مصنوعی میتواند بهراحتی تکثیر شود، مدیریت و کنترل آن نیز تنها به حاکمیت یک کشور مربوط نمیشود و مسئلهای جهانی است. علاوه بر این، آسیبی که هوش مصنوعی ممکن است وارد کند، هیچ سقف آشکاری ندارد؛ حتی اگر انگیزههای ساخت و مزایای انجام آن همچنان در حال افزایش باشد.

هوش مصنوعی میتواند برای تولید و انتشار اطلاعات نادرست و مخرب، از بین بردن سرمایه اجتماعی و دموکراسی، زیر نظر گرفتن مردم، دستکاری ذهن و تحت سلطه در آوردن شهروندان، تضعیف آزادیهای فردی و جمعی یا ایجاد سلاحهای دیجیتال یا فیزیکی قدرتمند که جان انسانها را تهدید میکند، استفاده شود. هوش مصنوعی همچنین میتواند میلیونها شغل را از بین ببرد، نابرابریهای موجود را بدتر کرده و مشاغل جدیدی ایجاد کند. هوش مصنوعی الگوهای تبعیضآمیز را تقویت میکند و با تقویت حلقههای ارائهدهنده اطلاعات منفی، تصمیمگیری را تحریف میکند یا باعث جرقه تشدید ناخواسته و غیرقابلکنترل نظامی منجر به جنگ میشود.

همچنین چارچوب زمانی برای بزرگترین خطرات در ارتباط با هوش مصنوعی هنوز مشخص نیست. «اطلاعات غلط آنلاین»، یک تهدید کوتاهمدت آشکار است و ایجاد جنگ غیرارادی در میانمدت، قابلقبول به نظر میرسد. در افق دورتر «هوش عمومی مصنوعی» [8] قرار دارد که هنوز نقطه نامشخصی است و در آن هوش مصنوعی از عملکرد انسان در هر کار معینی فراتر میرود و خطر محتملی که وجود دارد این است که هوش عمومی مصنوعی به هدایت، بهبود و بازسازی خود خارج از کنترل انسان بپردازد.

هوش مصنوعی اولین فناوری با برخی از این ویژگیهای قوی نیست، اما اولین فناوری است که همه آنها را با هم ترکیب میکند. سیستمهای هوش مصنوعی مانند اتومبیلها یا هواپیماها نیستند که بر روی سختافزاری ساخته شده باشند که در معرض پیشرفتهای تدریجی هستند و پرهزینهترین خرابیهای آنها بهصورت تصادفات فردی رخ میدهد. آنها همچنین مانند سلاحهای شیمیایی یا هستهای نیستند که توسعه و نگهداری - چه رسد بهاشتراکگذاری یا استقرار مخفیانه آنها - دشوار و پرهزینه باشد. همانطور که مزایای عظیم آنها بدیهی است، سیستمهای هوش مصنوعی بزرگتر، بهتر، ارزانتر و فراگیرتر خواهند شد. آنها حتی قادر به شبه خودمختاری یعنی قادر به دستیابی به اهداف مشخص با حداقل نظارت انسانی و به طور بالقوه برای بهبود خود خواهند شد. هر یک از این ویژگیها، مدلهای حاکمیت سنتی را به چالش میکشد.

جایی برای تعلل نیست

هوش مصنوعی با تغییر ساختار و توازن قدرت جهانی، زمینه سیاسی نظارت بر خود را پیچیده میکند. هوش مصنوعی طبق معمول فقط توسعه نرمافزار نیست. این یک ابزار کاملاً جدید برای نمایش قدرت است. در برخی موارد، مقامات موجود را سرنگون خواهد کرد و در برخی موارد دیگر میتواند جایگاه آنها را تثبیت کند. علاوه بر این، پیشرفت آن توسط انگیزههای مقاومتناپذیری پیش میرود: هر ملت، شرکت و فردی، نسخهای از آن را میخواهد. در داخل کشورها، هوش مصنوعی به کسانی که از آنها برای نظارت، فریب و حتی کنترل جمعیت استفاده میکنند، قدرت میدهد و ابزار سرکوب را در اختیار دولتهای مستبد برای تسلط بر جوامع خود قرار میدهند. در دموکراسیها نیز از هوش مصنوعی برای جمعآوری و استفاده تجاری از دادههای شخصی استفاده میشود.

در میان همه کشورها، هوش مصنوعی کانون رقابت شدید ژئوپلیتیکی خواهد بود. برتری هوش مصنوعی، به دلیل قابلیتهای سرکوبکننده، پتانسیل اقتصادی یا مزیت نظامی، هدف استراتژیک هر دولتی برای رقابت با سایر دولتها خواهد بود. دولتها از تلاشگران بومی هوش مصنوعی با پمپاژ پول به آنها حمایت میکنند یا سعی میکنند ابررایانهها و الگوریتمها را خود تولید و کنترل کنند. فرانسه با حمایت مستقیم از استارتآپهای هوش مصنوعی، بریتانیا با سرمایهگذاری بر دانشگاههای کلاس جهانی و اتحادیه اروپا با شکلدادن به گفتگوی جهانی در مورد مقررات و هنجارها به دنبال آن هستند که مزیتهای رقابتی خاصی را در این زمینه تقویت کنند.

اکثریت قریب به اتفاق کشورها نه پول و نه دانش فنی لازم برای رقابت برای رهبری هوش مصنوعی را ندارند. دسترسی آنها به هوش مصنوعی بستگی به روابط آنها با تعداد انگشت شماری از شرکتها و دولتهای ثروتمند و قدرتمند دارد. این وابستگی، تهدیدی برای تشدید عدم تعادل قدرت ژئوپلیتیکی فعلی است. قدرتمندترین دولتها برای کنترل ارزشمندترین منبع جهان رقابت خواهند کرد؛ در حالی که بار دیگر، کشورهای جنوب جهان، عقب خواهند ماند. این بدان معنا نیست که فقط ثروتمندترینها از انقلاب هوش مصنوعی سود میبرند. مانند اینترنت و گوشیهای هوشمند، امکان استفاده از دستاوردهای هوش مصنوعی که به صورت آزادانه تکثیر میشود. برای بسیاری از دولتها امکانپذیر خواهد بود. با این حال، در سوی دیگر معادله ژئوپلیتیک، رقابت برای برتری هوش مصنوعی شدید خواهد بود. در پایان جنگ سرد، کشورهای قدرتمند ممکن بود برای رفع ترس و نگرانی یکدیگر و جلوگیری از یک مسابقه تسلیحاتی بیثباتکننده بالقوه، همکاری کنند. اما محیط پرتنش ژئوپلیتیک امروزی، امکان چنین همکاریهایی را بسیار سختتر میکند. هوش مصنوعی، دیگر تنها یک ابزار یا سلاح نیست که بتواند اعتبار، قدرت یا ثروت برای کشورها به ارمغان بیاورد؛ بلکه این پتانسیل را دارد که مزیت نظامی و اقتصادی قابلتوجهی را نسبت به دشمنان ایجاد کند. درست یا غلط، دو بازیگری که بیشترین اهمیت را دارند - چین و ایالات متحده - هر دو توسعه هوش مصنوعی را یک بازی با حاصل جمع جبری صفر میدانند که پیروزی یک طرف به منزله شکست طرف مقابل خواهد بود و به برنده یک مزیت استراتژیک تعیینکننده در دهههای آینده خواهد داد.

مدیریت هوش مصنوعی نیازمند یک تصمیم جامع جهانی است. اگر در کشوری هوش مصنوعی مهار نشود، کنترل آن در دیگر کشورها ارزشی نخواهد داشت.

از منظر واشنگتن و پکن، خطر اینکه طرف مقابل در هوش مصنوعی برتری پیدا کند، بیشتر از هر خطر تئوریک دیگری است که فناوری ممکن است برای جامعه یا اقتدار سیاسی داخلی آنها ایجاد کند. به همین دلیل، آمریکا و چین منابع عظیمی را برای توسعه قابلیتهای هوش مصنوعی سرمایهگذاری میکنند و در عین حال تلاش میکنند یکدیگر را از دادههای موردنیاز برای پیشرفتهای نسل بعدی محروم کنند. تا کنون ایالات متحده در انجام دومی بهویژه با کنترل صادرات خود بر روی نیمههادیهای پیشرفته، بسیار موفقتر از چین بوده است.

این پویایی حاصل جمع صفر و عدم اعتماد متقابل بین هر دو طرف به این معنی است که پکن و واشنگتن، به جای کاهش سرعت توسعه هوش مصنوعی بر سرعتبخشیدن به توسعه هوش مصنوعی متمرکز هستند. از نظر آنها، «مکث» یا «توقف» در توسعه هوش مصنوعی برای ارزیابی خطرات، همانطور که برخی از رهبران صنعت هوش مصنوعی خواستار آن شدهاند، به منزله خلع سلاح یکجانبه و احمقانه خود است. اما این دیدگاه فرض میکند که دولتها میتوانند کنترل حداقلی بر هوش مصنوعی داشته باشند. این ممکن است در مورد چین صادق باشد چرا که شرکتهای فناوری خود را در ساختار دولتی ادغام کرده است. با این حال در غرب و جاهای دیگر، هوش مصنوعی به احتمال زیاد قدرت دولت را به جای تقویت، تضعیف میکند. در خارج از چین، تعداد انگشت شماری از شرکتهای بزرگ و متخصص هوش مصنوعی در حال حاضر همه جنبههای این موج فناوری جدید را کنترل میکنند. این چند شرکت ممکن است مزیت خود را برای آینده قابلپیشبینی حفظ کنند. یا ممکن است تحتالشعاع تعداد زیادی از بازیگران کوچکتر قرار بگیرند؛ زیرا موانع کم برای ورود و توسعه منبعباز و هزینههای حاشیهای تقریباً صفر، منجر به تکثیر کنترل نشده هوش مصنوعی میشود. در هر صورت، انقلاب هوش مصنوعی خارج از دولت اتفاق خواهد افتاد.

برخی از چالشها در زمینه هوش مصنوعی تا حدودی به چالشهای فناوریهای دیجیتال قبلی شباهت دارند. پلتفرمهای اینترنتی، رسانههای اجتماعی و حتی دستگاههایی مانند گوشیهای هوشمند، همگی تا حدی در چارچوبهایی که توسط سازندگانشان کنترل میشود، کار میکنند. هنگامی که دولتها اراده سیاسی خود را به کار گرفتند، توانستند رژیمهای نظارتی مانند مقررات حفاظت از دادههای عمومی اتحادیه اروپا، قانون بازارهای دیجیتال و قانون خدمات دیجیتال را برای این فناوریها اجرا کنند. اما اجرای چنین مقرراتی در اتحادیه اروپا یک دهه یا بیشتر طول کشید و هنوز به طور کامل در آمریکا تحقق نیافته است.

هوش مصنوعی با سرعتی خیلی زیاد در حال پیشرفت است و سیاستگذاران نمیتوانند با سرعت معمول خود به آن پاسخ دهند. علاوه بر این، رسانههای اجتماعی و سایر فناوریهای دیجیتال قدیمیتر به ایجاد خود کمکی نمیکنند و منافع تجاری و استراتژیکی که آنها را هدایت میکنند، هرگز به یک شکل کاملاً یکسان نبوده است. بهعنوانمثال توییتر و تیکتاک قدرتمند هستند، اما تعداد کمی فکر میکنند که این دو میتوانند اقتصاد جهانی را متحول کنند.

همه اینها بدان معنی است که حداقل برای چند سال آینده، مسیر هوش مصنوعی صرفنظر از اینکه سیاستگذاران در اتحادیه اروپا یا آمریکا چه میکنند، تا حد زیادی توسط تصمیمات تعداد انگشت شماری از مشاغل خصوصی تعیین میشود. بهعبارتدیگر، فناوران و نه سیاستگذاران یا بوروکراتها، بر نیرویی اعمال قدرت خواهند کرد که میتواند هم قدرت دولت - ملتها و هم نحوه ارتباط آنها با یکدیگر را تغییر دهد. این باعث میشود که چالش حاکم بر هوش مصنوعی متفاوت از هر چیزی باشد که دولتها تاکنون با آن روبرو بودهاند.

ضرورت مدیریت جامع هوش مصنوعی

دولتها در حال حاضر در زمینه سیاستگذاری و مدیریت هوش مصنوعی عقب هستند. اکثر طرحهای پیشنهادی برای مدیریت و کنترل هوش مصنوعی، آن را بهعنوان یک مشکل متعارف در نظر میگیرد که با راهحلهای دولتمحور قرن بیستم قابل حلوفصل است. تصمیمی که توسط رهبران سیاسی که دور یک میز نشستهاند گرفته میشود، برای هوش مصنوعی کارساز نخواهد بود. تلاشهای نظارتی تا به امروز در مراحل ابتدایی خود بوده و هنوز ناکافی هستند. قانون هوش مصنوعی اتحادیه اروپا بلندپروازانهترین تلاش برای مدیریت و نظارت بر هوش مصنوعی است، اما این قانون تنها از سال ۲۰۲۶ به طور کامل اعمال میشود و تا آن زمان، مدلهای هوش مصنوعی فراتر از تصور پیشرفت خواهند کرد. بریتانیا رویکردی حتی آزادتر و داوطلبانهتر را برای تنظیم هوش مصنوعی پیشنهاد کرده است، اما این روش، فاقد قابلیت اجرایی و کاملاً غیرمؤثر است. هیچ یک از این ابتکارات، تلاشی برای مدیریت توسعه و استقرار هوش مصنوعی در سطح جهانی ندارد؛ چیزی که برای موفقیت حکمرانی هوش مصنوعی ضروری است. تعهدات داوطلبانه توسعهدهندگان هوش مصنوعی برای احترام به دستورالعملهای ایمنی هم هیچ جایگزینی برای مقررات ملی و بینالمللی الزامآور قانونی نیست.

حامیان توافقات در سطح بینالمللی، برای مهار هوش مصنوعی تمایل دارند به مدلی مانند کنترل تسلیحات هستهای دست یابند. اما توسعه، سرقت و کپیکردن سیستمهای هوش مصنوعی نهتنها از سلاحهای هستهای بسیار آسانتر است، بلکه آنها توسط شرکتهای خصوصی - نه دولتها - کنترل میشوند. از آنجایی که نسل جدید مدلهای هوش مصنوعی، سریعتر از همیشه منتشر میشوند، مقایسه آنها با سلاحهای هستهای، مقایسه غلطی به نظر میرسد؛ حتی اگر دولتها بتوانند با موفقیت دسترسی به مواد موردنیاز برای ساخت پیشرفتهترین مدلها را کنترل کنند. همچنان که دولت بایدن با جلوگیری از دستیابی چین به تراشههای پیشرفته، تلاش خود را میکند؛ اما پس از تولید، نمیتوانند جلوی تکثیر این مدلها را بگیرند.

برای اینکه حکمرانی جهانی هوش مصنوعی بهدرستی کار کند، باید با ماهیت خاص فناوری، چالشهایی که ایجاد میکند و ساختار و توازن قدرتی که در آن عمل میکند، تنظیم شود. اما از آنجایی که تکامل، کاربردها، خطرات و پاداشهای هوش مصنوعی، غیرقابلپیشبینی است، نمیتوان در ابتدا یا در هر مقطع زمانی دیگری چگونگی مدیریت هوش مصنوعی را به طور کامل مشخص کرد. باید مدیریت و نظارت بر هوش مصنوعی به اندازه خود این فناوری، نوآورانه و تکاملگرا باشد و دارای برخی از ویژگیهایی باشد که در وهله اول هوش مصنوعی را به چنین نیروی قدرتمندی تبدیل کرده است. این به معنای شروع از صفر، بازاندیشی و بازسازی یک چارچوب نظارتی جدید از پایه است.

باید هدف کلی هر معماری نظارتی هوش مصنوعی جهانی، شناسایی و کاهش خطرات برای ثبات جهانی بدون خفه کردن نوآوری هوش مصنوعی و فرصتهای ناشی از آن باشد. این رویکرد را «احتیاط گرایی فناورانه» [9] بنامید؛ دستوری که بیشتر شبیه نقش احتیاطی و پیشگیرانه کلاننهادهای مالی جهانی مانند «هیئت ثبات مالی» [10]، «بانک تسویهحسابهای بینالمللی» [11] و «صندوق بینالمللی پول» است. هدف آنها شناسایی و کاهش خطرات برای ثبات مالی جهانی، بدون به خطر انداختن رشد اقتصادی است.

یک دستور فنی احتیاطی نیز به همین شکل عمل میکند و ایجاد مکانیسمهای نهادی برای رسیدگی به جنبههای مختلف هوش مصنوعی که میتواند ثبات ژئوپلیتیک جهان را تهدید کند، ضروری است. این مکانیسمها به نوبه خود توسط اصول مشترکی هدایت میشوند که هم بر اساس ویژگیهای منحصربهفرد هوش مصنوعی طراحی شدهاند و هم منعکسکننده موازنه جدید قدرت مبتنی بر فناوری هستند که شرکتهای فناوری را در موقعیت رهبری قرار داده است. این اصول به سیاستگذاران کمک میکند تا چارچوبهای نظارتی دقیقتری برای کنترل و اداره هوش مصنوعی در حالی که تکامل مییابد و به یک نیروی فراگیرتر تبدیل میشود، ترسیم کنند.

اولین و شاید حیاتیترین اصل برای حکمرانی هوش مصنوعی، پیشگیری و احتیاط است. همانطور که از این اصطلاح پیداست، فناوری در هستة خود با این باور پیشگیرانه هدایت میشود: اول، آسیبی نرسانید. محدودکردن حداکثری هوش مصنوعی به معنای کنارگذاشتن جنبههای مثبت آن است که زندگی را تغییر میدهد، اما آزادسازی حداکثری آن به معنای آزادسازی تمام جنبههای منفی بالقوه فاجعهبار آن است. بهعبارتدیگر، نمودار ریسک - مزیت، برای هوش مصنوعی نامتقارن است. با توجه به عدم قطعیت شدید در مورد مقیاس و برگشتناپذیری برخی از آسیبهای بالقوه هوش مصنوعی، مدیریت هوش مصنوعی باید به جای کاهشدادن آنها قبل از تحقق، به دنبال پیشگیری از این خطرات قبل از وقوع آنها باشد. این امر بسیار مهم است؛ زیرا هوش مصنوعی میتواند دموکراسی را در برخی کشورها تضعیف کند و وضع مقررات را برای آنها دشوارتر کند. علاوه بر این، مسئولیت اثبات ایمن بودن یک سیستم هوش مصنوعی باید بر عهده توسعهدهنده و مالک آن باشد. این مسئله نباید صرفاً به عهده دولتها باشد که بهمحض بروز مشکلات با آنها برخورد کنند.

همچنین مدیریت و اداره هوش مصنوعی باید چابک باشد تا بتواند مسیر خود را با تکامل و بهبود هوش مصنوعی تطبیق داده و اصلاح کند. مؤسسات دولتی اغلب به حدی میرسند که قادر به انطباق با تغییرات نیستند و در مورد هوش مصنوعی، سرعت بالای پیشرفت فناوری بهسرعت بر توانایی ساختارهای حاکمیتی موجود غلبه خواهد کرد. این بدان معنا نیست که حکمرانی هوش مصنوعی باید اخلاق «سیلیکونولی» یعنی «سریع حرکت کنید و چیزها را بشکنید» را اتخاذ کند، اما باید ماهیت فناوری را که میخواهد در بر بگیرد، بیشتر منعکس کند.

علاوه بر احتیاط و چابکی، حکمرانی هوش مصنوعی باید فراگیر باشد و از همه بازیگران لازم برای تنظیم عملی هوش مصنوعی دعوت به همکاری کند. این بدان معناست که مدیریت و نظارت بر هوش مصنوعی نمیتواند منحصراً دولتمحور باشد، زیرا دولتها هوش مصنوعی را نه درک و نه کنترل میکنند. شرکتهای فناوری خصوصی ممکن است فاقد حاکمیت به معنای سنتی باشند، اما در فضاهای دیجیتالی که ایجاد کردهاند و به طور مؤثر بر آن حکومت میکنند، از قدرت و اختیار واقعی - حتی حاکمیتی - برخوردارند. این بازیگران غیردولتی نباید مانند دولتهایی که در عرصه بینالمللی شهروندان خود را نمایندگی میکنند، از حقوق و امتیازات یکسانی برخوردار شوند؛ اما آنها باید طرفهای نشستهای بینالمللی باشند و هر گونه توافقنامهای را درباره هوش مصنوعی امضا کنند.

هوش مصنوعی مفاهیم سنتی قدرت ژئوپلیتیک را تغییر داده است و نمیتوان مانند فناوریهای قبلی آن را مدیریت کرد.

مدیریت گسترده و فراگیر هوش مصنوعی ضروری است؛ زیرا هر ساختار نظارتی که عوامل واقعی قدرت هوش مصنوعی را کنار بگذارد، محکوم به شکست است. در موجهای قبلی مقررات فناوری، اغلب به شرکتها آزادی عمل زیادی داده میشد که فراتر از آن عمل میکردند و باعث میشد سیاستگذاران و تنظیمکنندهها بهشدت نسبت به افراطگرایی آنها واکنش نشان دهند؛ اما این پویایی نه برای شرکتهای فناوری و نه برای مردم سودی نداشت. دعوت از توسعهدهندگان هوش مصنوعی برای مشارکت در فرایند قانونگذاری از همان ابتدا به ایجاد فرهنگ مشارکتیتر مدیریت هوش مصنوعی کمک میکند و نیاز به مهار این شرکتها را بعد از این واقعیت با مقررات پرهزینه و خصمانه کاهش میدهد.

شرکتهای فناوری همیشه نباید در همه مراحل مدیریت هوش مصنوعی حضور داشته باشند. برخی از جنبههای حکمرانی هوش مصنوعی بهتر است به دولتها واگذار شود و ناگفته نماند که دولتها باید همیشه حق وتوی نهایی را در تصمیمگیریهای سیاسی حفظ کنند. دولتها همچنین باید از نفوذ و لابیگری شرکتها جلوگیری کنند تا اطمینان حاصل نمایند که شرکتهای فناوری از نفوذ خود در سیستمهای سیاسی برای پیشبرد منافع خود به بهای منافع عمومی استفاده نمیکنند.

اما یک مدل مدیریتی فراگیر و چندجانبه، تضمین میکند که بازیگرانی که سرنوشت هوش مصنوعی را تعیین میکنند، در فرآیندهای قانونگذاری مشارکت دارند و متعهد به اجرای این قوانین هستند. علاوه بر دولتها - نه فقط چین و ایالات متحده آمریکا - و شرکتهای فناوری - نه محدود به بازیگران بزرگ فناوری - ، دانشمندان، فلاسفه علم اخلاق، اتحادیههای کارگری، سازمانهای جامعه مدنی و دیگر صاحبنظرانی که از نتایج هوش مصنوعی آگاه هستند یا سهمی در قدرتیابی آن دارند باید دور میز مذاکره درباره مدیریت و نظارت بر هوش مصنوعی حضور داشته باشند. حکمرانی هوش مصنوعی باید جامع و بیعیبونقص باشد؛ به این معنی که ورود به آن بهاندازه کافی آسان باشد که امکان مشارکت را تشویق و خروج از آن بهاندازه کافی سخت و پرهزینه باشد تا از عدم رعایت مقررات جلوگیری کند. یک حفره یا پیوند ضعیف در این فرایند، زمینهساز رسوخ و نشت گسترده اطلاعات، بازیگران بد و یا ایجاد یک مسابقه نظارتی باز میشود.

علاوه بر پوشش کل جهان، حاکمیت هوش مصنوعی باید کل زنجیره تأمین از تولید گرفته تا سختافزار، نرمافزار، خدمات و ارائهدهندگان و کاربران را پوشش دهد. این به معنای نظارت فنی بر هر گره از زنجیره ارزش هوش مصنوعی - از تولید تراشههای هوش مصنوعی گرفته تا جمعآوری دادهها، آموزش مدلسازی، استفاده نهایی و در سراسر مجموعه فناوریهای مورداستفاده در یک برنامه خاص - است. چنین نفوذناپذیری تضمین میکند که هیچ ناحیه خاکستری نظارتی برای سوءاستفاده وجود ندارد.

در نهایت حکمرانی هوش مصنوعی باید هدفمند باشد، نه اینکه یک اندازه برای همه باشد. از آنجایی که هوش مصنوعی یک فناوری چندمنظوره است، تهدیدات چندبعدی را نیز به همراه دارد؛ لذا یک ابزار مدیریتی واحد برای رسیدگی به منابع مختلف خطر هوش مصنوعی کافی نیست. در عمل، تعیین اینکه کدام ابزارها برای هدف قراردادن ریسکها مناسب هستند، مستلزم ایجاد یک طبقهبندی پویا از تمام اثرات احتمالی هوش مصنوعی و اینکه چگونه میتوان هر کدام را به بهترین نحو کنترل کرد، میباشد. بهعنوانمثال، هوش مصنوعی در برخی از برنامهها تکاملی و تدریجی خواهد بود؛ مشکلات فعلی مانند نقض حریم خصوصی را تشدید میکند و در برخی دیگر انقلابی و بنیادین است و آسیبهای کاملاً جدیدی ایجاد میکند. گاهی اوقات بهترین مکان برای مداخله، جایی است که دادهها جمعآوری میشوند. در مواقع دیگر، این نقطهای است که تراشههای پیشرفته به فروش میرسند و اطمینان حاصل میشود که در جای اشتباهی قرار نمیگیرند. مقابله با اطلاعات نادرست و اطلاعات عمداً نادرست، به ابزارهای متفاوتی نسبت به مقابله با خطرات «هوش مصنوعی عمومی» و سایر فناوریهای نامطمئن با پیامدهای بالقوه وجودی نیاز دارد. یک نظارت جزئی از سوی شرکتهای پیشرفته فناوری در این زمینه کارساز خواهد بود. در برخی موارد دیگر، دولتها باید بهشدت وارد عمل شوند.

همه اینها مستلزم درک عمیق و دانش بهروز فناوریهای موردنظر است؛ رگولاتورها و سایر مقامات به نظارت و دسترسی به مدلهای کلیدی هوش مصنوعی نیاز دارند. تنها چنین اقداماتی میتواند تضمین کند که برنامههای هوش مصنوعی جدید به طور فعال، هم برای خطرات آشکار و هم برای پیامدهای بالقوه، مخرب ارزیابی میشوند. بهعبارتدیگر، مدیریت هدفمند هوش مصنوعی باید مدیریتی آگاهانه باشد.

الزامات احتیاطی و پیشگیرانه فنی

بر اساس اصولی که گفته شد، باید حداقل سه رژیم حکمرانی هوش مصنوعی وجود داشته باشد که هر کدام دارای وظایف، اهرمها و شرکتکنندگان متفاوتی هستند. همه باید از نظر طراحی جدید باشند، اما هر کدام میتوانند به دنبال الهامگرفتن از ترتیبات موجود برای پرداختن به سایر چالشهای جهانی یعنی تغییرات آبوهوایی، تکثیر تسلیحات و ثبات مالی باشند. رژیم اول بر حقیقتیابی تمرکز میکند و به شکل یک نهاد علمی جهانی است که به طور عینی به دولتها و نهادهای بینالمللی درباره مسائلی اساسی مانند اینکه هوش مصنوعی چیست و چه نوع چالشهای سیاستی ایجاد میکند، مشاوره میدهد.

اگر هیچکس نتواند در مورد تعریف هوش مصنوعی یا دامنه احتمالی آسیبهای آن توافق کند، سیاستگذاری مؤثر غیرممکن خواهد بود. این نهاد دارای استقلال علمی و ژئوپلیتیکی جهانی خواهد بود و همانطور که برنامه بیندولتی تغییرات آبوهوایی (IPCC) - وابسته به سازمان ملل - گزارشهای مذاکرات آبوهوایی سازمان ملل را منعکس میکنند، گزارشهای این نهاد نیز میتواند به مذاکرات چندجانبه در مورد هوش مصنوعی کمک کند.

جهان همچنین به راهی برای مدیریت تنشها بین قدرتهای اصلی هوش مصنوعی و جلوگیری از گسترش سیستمهای خطرناک هوش مصنوعی پیشرفته نیاز دارد. مهمترین رابطه بینالمللی در هوش مصنوعی، رابطه بین ایالات متحده و چین است. دستیابی به همکاری بین دو رقیب در بهترین شرایط دشوار است، اما در زمینه رقابت ژئوپلیتیک تشدید شده، یک مسابقه هوش مصنوعی کنترل نشده، میتواند تمام امیدها برای ایجاد یک اجماع بینالمللی در مورد حکمرانی هوش مصنوعی را از بین ببرد. یکی از زمینههایی که واشنگتن و پکن ممکن است همکاری با یکدیگر را مفید بدانند، کند کردن گسترش سیستمهای قدرتمندی است که میتوانند اقتدار دولت - ملتها را به خطر بیندازند. در نهایت، احتمال تهدید هوشهای مصنوعی عمومی کنترل نشده و خودتکثیرشونده در سالهای آینده وجود دارد و انگیزههای قوی برای هماهنگی در مورد ایمنی و مهار ایجاد میکند.

در تمام این جبههها، واشنگتن و پکن باید به دنبال ایجاد زمینههای مشترک و راهکارهای احتیاطی پیشگیرانه باشند که توسط یک طرف ثالث پیشنهاد و کنترل میشود. در اینجا رویکردهای نظارتی و راستیآزمایی که اغلب در رژیمهای کنترل تسلیحات یافت میشوند، ممکن است برای مهمترین ورودیهای هوش مصنوعی - بهویژه ورودیهای مربوط به سختافزار محاسباتی - از جمله نیمه رسانههای پیشرفته و مراکز داده، اعمال شوند. مدیریت نقاط اختلاف استراتژیک در طول دوران جنگ سرد به مهار یک مسابقه تسلیحاتی خطرناک کمک کرد و میتواند در حال حاضر به مهار یک مسابقه هوش مصنوعی حتی خطرناکتر نیز کمک کند.

اما از آنجایی که بیشتر حوزههای هوش مصنوعی در حال حاضر غیرمتمرکز است، فراتر از مسئله بین دو ابرقدرت، به یک مشکل مشترک جهانی تبدیل شده است. ماهیت توسعه هوش مصنوعی و ویژگیهای اصلی این فناوری، مانند تکثیر منبعباز، این احتمال را افزایش میدهد که توسط مجرمان سایبری، بازیگران تحت حمایت دولت و تروریستهایی که انفرادی عمل میکنند به سلاح تبدیل شود؛ به همین دلیل است که جهان به یک رژیم حکمرانی هوش مصنوعی سوم نیاز دارد که بتواند در هنگام بروز اختلالات خطرناک واکنش نشان دهد. برای مدلها، سیاستگذاران ممکن است به رویکردی نگاه کنند که مقامات مالی برای حفظ ثبات مالی جهانی استفاده کردهاند. هیئت ثبات مالی، متشکل از بانکهای مرکزی، وزارتهای دارایی و مقامات نظارتی از سراسر جهان، برای جلوگیری از بیثباتی مالی جهانی با ارزیابی آسیبپذیریهای سیستمی و هماهنگی اقدامات لازم برای رفع آنها در بین مقامات ملی و بینالمللی تلاش میکند. یک نهاد تکنوکراتیک مشابه برای ریسک هوش مصنوعی - که آن را میتوان هیئت ثبات ژئو تکنولوژی نامید - میتواند برای حفظ ثبات ژئوپلیتیک در میان تغییرات سریع مبتنی بر هوش مصنوعی عمل کند. چنین نهادی با قدرتی که ریشه در حمایت دولت دارد، میتواند جلوی دورزدن مقررات را بگیرد.

رژیمی که برای حفظ ثبات ژئو تکنولوژیک طراحی شده است، خلأ خطرناکی مثل مسئولیت حاکمیت بر هوش مصنوعی منبعباز را در چشمانداز نظارتی کنونی پر میکند. سطحی از سانسور آنلاین ضروری خواهد بود؛ اگر شخصی یک مدل بسیار خطرناک را آپلود کند، این سازمان باید دارای اختیار و توانایی آشکاری باشد که آن را حذف کند یا مقامات ملی را برای انجام این کار هدایت کند. این یکی دیگر از زمینههای همکاری بالقوه دوجانبه است. چین و آمریکا باید برای تعبیه محدودیتهای ایمنی در نرمافزار متنباز با یکدیگر همکاری کنند. برای مثال، چین و آمریکا میتوانند درباره محدودکردن میزانی که مدلهای هوش مصنوعی میتوانند به کاربران در مورد چگونگی توسعه سلاحهای شیمیایی یا بیولوژیکی یا ایجاد عوامل بیماریزای همهگیر آموزش دهند، همکاری کنند. علاوه بر این، ممکن است فضایی برای پکن و واشنگتن برای همکاری در تلاشهای جهانی ضد اشاعه، از جمله از طریق استفاده از ابزارهای سایبری مداخلهجویانه وجود داشته باشد. هر یک از این رژیمها باید بهصورت جهانی عمل کند و از مشارکت و همکاری همه بازیگران اصلی هوش مصنوعی بهرهمند شود. رژیمها باید به اندازه کافی تخصص باشند تا بتوانند با سیستمهای هوش مصنوعی واقعی کنار بیایند و به اندازه کافی پویا باشند تا دانش خود را از هوش مصنوعی در حین تکامل بهروز کنند.

این مؤسسات با همکاری یکدیگر میتوانند گامی تعیینکننده به سمت مدیریت فنی در دنیای نوظهور هوش مصنوعی بردارند. اما آنها بههیچوجه تنها نهادهایی نیستند که موردنیاز خواهند بود. مکانیسمهای نظارتی دیگری مانند استانداردهای شفافیت همچون «مشتری خود را بشناسید»، الزامات مجوز، پروتکلهای تست ایمنی و فرآیندهای ثبت و تأیید محصول، باید در چند سال آینده برای هوش مصنوعی اعمال شوند. کلید همه این ایدهها، ایجاد نهادهای حکومتی انعطافپذیر و چندوجهی خواهد بود که توسط سنت یا فقدان خلاقیت محدود نشده باشند.

بهترینها را تبلیغ و از بدترینها جلوگیری کنید

هوش مصنوعی با تغییر ساختار و توازن قدرت جهانی، زمینه سیاسی نظارت بر خود را پیچیده میکند.

اجرای هیچ یک از این راهحلها آسان نخواهد بود؛ علیرغم همه هیاهوها و صحبتهایی که از سوی رهبران جهان در موردنیاز به تنظیم هوش مصنوعی گفته میشود، هنوز اراده سیاسی برای انجام این کار وجود ندارد. یک رژیم حکمرانی هوش مصنوعی از نوع توصیف شده در اینجا میتواند برای همه طرفهای ذینفع مناسب باشد و اصول و ساختارهایی که بهترینها را در هوش مصنوعی ترویج میکنند و در عین حال از بدترینها جلوگیری میکند، حفظ مینماید.

جایگزین هوش مصنوعی غیرقابلکنترل، فقط خطرات غیرقابلقبول برای ثبات جهانی نخواهد بود؛ بلکه هوش مصنوعی غیرقابلکنترل برای تجارت نیز مضر خواهد بود و با منافع ملی کشورها نیز مغایرت دارد. یک رژیم نظارتی قوی هوش مصنوعی، هم خطرات اجتماعی ناشی از هوش مصنوعی را کاهش میدهد و هم تنشهای بین چین و ایالات متحده را با کاهش میزان تبدیلشدن هوش مصنوعی به عرصه و ابزار رقابت ژئوپلیتیکی میکاهد. چنین رژیمی به چیزی عمیقتر و طولانیتر منجر میشود. یک رژیم نظارتی قوی در زمینه هوش مصنوعی، الگویی برای نحوه رسیدگی به سایر فناوریهای مخرب و نوظهور ایجاد میکند. هوش مصنوعی ممکن است یک کاتالیزور منحصربهفرد برای تغییر باشد، اما بههیچوجه آخرین فناوری مخربی نیست که بشریت با آن مواجه خواهد شد. محاسبات کوانتومی، بیوتکنولوژی، نانوتکنولوژی و رباتیک نیز پتانسیل تغییر اساسی جهان را دارند. مدیریت موفقیتآمیز هوش مصنوعی به جهان کمک میکند تا این فناوریها را نیز با موفقیت اداره کند.

قرن بیست و یکم چالشهای کمی بهاندازه چالشهای دلهرهآور یا فرصتهای امیدوارکنندهای بهاندازه فرصتهای ارائهشده توسط هوش مصنوعی ارائه خواهد کرد. در قرن گذشته، سیاستگذاران شروع به ساختن یک معماری حکمرانی جهانی کردند که امیدوار بودند با وظایف عصر خود برابری کند. اکنون آنها باید یک معماری حکومتی جدید بسازند تا مهیبترین و تعیینکنندهترین نیروی بالقوه این دوران را مدیریت و مهار کند. سال ۲۰۳۵ نزدیک است و هیچ زمانی برای هدردادن وجود ندارد.

[1] . IAN BREMMER

[2] . MUSTAFA SULEYMAN

[3] . Technopolar: مفهوم« تکنوپولار» یا دنیای فناوری قطبی اشاره به یک نظریه یا تحلیل جهانی دارد که در آن فناوری نقش محوری در تعیین ساختار قدرت و نفوذ در سطح جهانی دارد. این دنیایی است که شرکتهای فناوری در آن نفوذ بیسابقهای در صحنه جهانی دارند، جایی که حاکمیت و نفوذ توسط قلمرو فیزیکی یا قدرت نظامی تعیین نمیشود و کنترل بر دادهها، سرورها و مهمتر از همه الگوریتمها حرف اول را میزند.

[4] . Hiroshima AI process

[5] . Moore’s Law

[6] . synapse: محل تماس دو عصب در مغز

[7] . large language models: مدل زبانی بزرگ (اختصاری LLM) یا الالام، سامانههای هوش مصنوعی هستند که برای درک، تولید و پاسخگویی به زبان انسان طراحی شدهاند. آنها «بزرگ» نامیده میشوند؛ زیرا حاوی میلیاردها پارامتر هستند که به آنها امکان میدهد الگوهای پیچیده در دادههای زبان را پردازش کنند.

[8] . Artificial general intelligence

[9] . Techno prudentialism

[10] . Financial Stability Board-FSB

[11] . Bank for International Settlements

/ انتهای پیام/